Hay pruebas suficientes de que el juicio humano se puede ver nublado por las emociones humanas, prejuicios o incluso niveles bajos de azúcar en la sangre, y de que esto puede tener graves consecuencias para el respeto de los derechos humanos.

Durante siglos, el derecho ha tenido esto en cuenta, formulando estándares como el hombre (o la mujer) “razonable”, o haciendo concesiones para la capacidad disminuida. La investigación sobre el sesgo cognitivo está en auge.

Por esta razón, muchos celebran nuestra creciente confianza en el análisis de grandes bases de datos y los algoritmos para ayudar (o incluso reemplazar) la toma de decisiones humana predictiva. Las herramientas de aprendizaje automático pueden discernir y aprender de patrones en datos masivos que la mente humana no puede procesar. Dichos procesos pueden resultar en autos que se conducen solos más seguros, diagnósticos médicos más precisos, o incluso mejores estrategias militares, y esto podría salvar muchas vidas.

Pero este poder computacional superior podría tener un profundo costo en los próximos años al hacer que perdamos la fe en nuestra propia capacidad para discernir la verdad y asignar responsabilidad por las malas decisiones. Sin alguien a quien hacer rendir cuentas, es casi imposible reivindicar los derechos humanos.

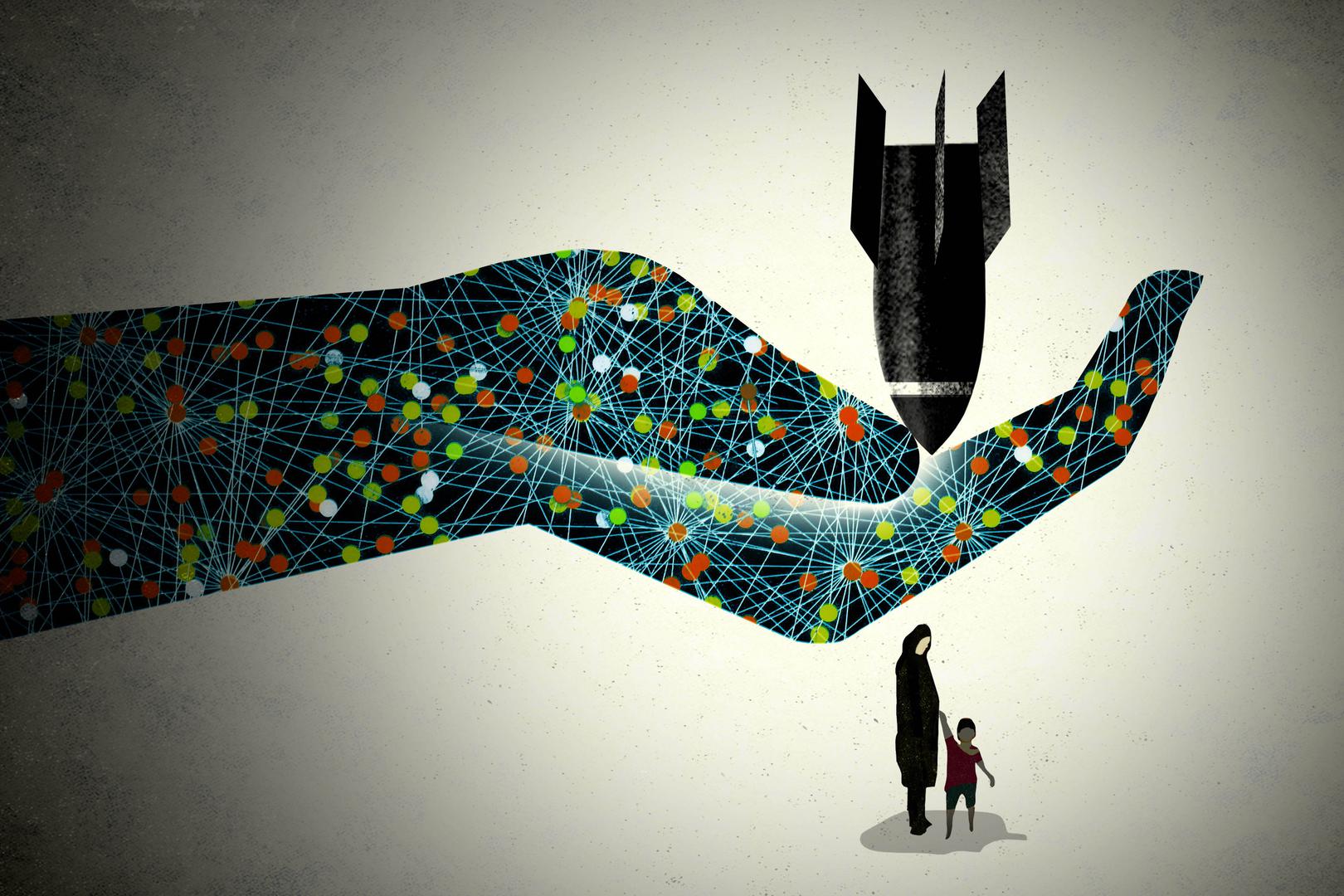

Ya existe una oposición generalizada al desarrollo de armas totalmente autónomas. Estas armas seleccionan y disparan contra objetivos sin la intervención de ningún control humano significativo. Incluso aquellos que creen que en el futuro estos “robots asesinos” podrían hacer un mejor trabajo minimizando las víctimas civiles que los humanos, una proposición ya de por sí altamente controvertida, podrían echarse atrás a la hora de dejar la decisión final en manos de algoritmos a los que es imposible hacer rendir cuentas. Ahora, tratemos de explicar a las víctimas de una masacre causada por armas automáticas que todo fue un problema de diseño del producto, no un crimen de guerra.

Otro problema es el reflejo político de exigir que los expertos tecnológicos de las redes sociales “solucionen” problemas como las noticias falsas o el lenguaje del odio. Las empresas regulan los clics y el efectivo, no el equilibrio sutil entre la promoción de la libre expresión en las sociedades democráticas y la protección de los derechos de los demás. Usarán algoritmos, no juristas bien entrenados, para determinar nuestros derechos, e incluso si pudieran explicar cómo es que sus herramientas toman decisiones, serían reacios a exponer secretos de propiedad intelectual.

La transparencia puede mitigar algunos problemas: si pudiéramos poner a prueba el algoritmo o auditar los datos de los que aprende, podrían hacerse correcciones. Los datos vienen con el prejuicio, la pobreza y la injusticia incrustados de nuestro mundo. Los datos parciales o incompletos pueden reforzar la toma de decisiones discriminatorias, como ha sido evidente en las herramientas que pretenden predecir el crimen, la reincidencia o la solvencia crediticia.

Pero la transparencia, incluso cuando es alcanzable, no puede resolver todos los problemas. Las decisiones de sentencia de un algoritmo bien entrenado podrían ser más “racionales” que las de un juez hambriento, enojado o con prejuicios. Sin embargo, ofende la dignidad humana absolver al juez de la responsabilidad de privar de libertad durante años a otra persona. El acto de escuchar verdaderamente a un acusado y conectar con la compasión, la empatía y la experiencia humana vivida de uno es tan esencial como el cálculo del riesgo para producir juicios justos y defender la dignidad humana. A veces, las soluciones al error humano requieren mejorar el juicio y la responsabilidad humana, no alentar su abdicación o atrofia.

Las herramientas de aprendizaje automático, como cualquier tecnología, constituyen un medio, no un fin. Cuando se les asigna un buen propósito, pueden promover la rendición de cuentas y los derechos. Deberíamos insistir en que estas herramientas estén siempre bajo el control humano, y que se apliquen sólo cuando mejoren los derechos humanos, los recursos contra las violaciones y la rendición de cuentas humana. Eso es una decisión política, y una que nuestros futuros Jefes Robot no pueden tomar.