تكثر الأدلّة التي تشير إلى احتمال تشوّش حكم الإنسان نتيجة مشاعره أو أحكامه المسبقة أو حتى انخفاض نسبة السكر في دمه، والعواقب الوخيمة التي قد تنتج عن ذلك على احترام حقوق الإنسان.

أخذت القوانين هذا الأمر في الحسبان على مرّ القرون لتضع معايير مثل الرجل "العاقل" (أو المرأة العاقلة)، أو لتعوّض عن تناقص القدرات. وتتكاثر الأبحاث حول التحيّز المعرفي.

لهذا السبب، يهلّل الكثيرون لزيادة اعتمادنا على البيانات الضخمة والخوارزميات لدعم عملية صنع القرار البشرية التنبؤية أو حتى الحلول محلها، إذ قد تستخرج أدوات التعلم الآلي الأنماط من البيانات الضخمة التي لا يستطيع العقل البشري استيعابها، وتتعلم منها. قد ينتج عن ذلك سيارات ذاتية القيادة أكثر أمانا، أو تشخيص طبي أكثر دقة، أو حتى استراتيجية عسكرية أفضل، ما قد ينقذ أرواح كثيرة.

لكن قد تكون تكلفة هذه القدرة الحاسوبية الفائقة باهظة في المستقبل، إذ قد تتسبّب في فقدان الإيمان في قدرتنا على معرفة الحقيقة وتحديد المسؤولية عن القرارات السيئة. في غياب مَن نحاسبه، يستحيل تقريبا الدفاع عن حقوق الإنسان.

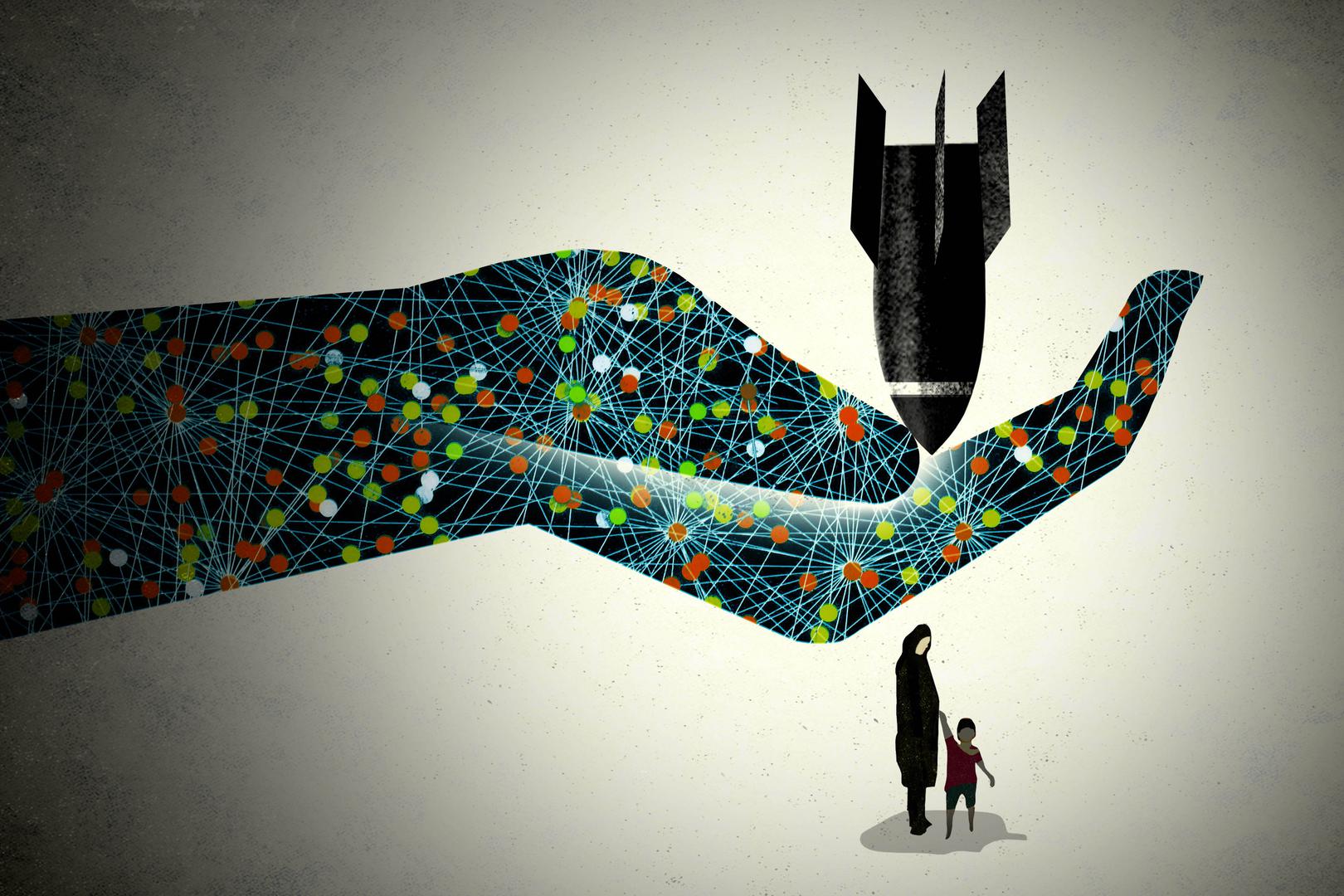

برزت بالفعل موجة معارضة واسعة النطاق لتطوير أسلحة ذاتية التحكم بالكامل، لأنها تستطيع تحديد أهدافها وإطلاق النار عليها من دون تحكم بشري فعلي. إذ حتى الأشخاص الذين يؤمنون بقدرة "الروبوتات القاتلة" يوما على تقليل الإصابات بين صفوف المدنيين مقارنة بالبشر، وهي فكرة مثيرة للكثير من الجدل بحد ذاتها، قد يترددون في ترك القرار النهائي لخوارزميات غير خاضعة للمساءلة. حاول أن تشرح لضحايا مذبحة ناجمة عن حسابات آلية أنّ ما حصل كان نتيجة لمشكلة في تصميم المنتج، وليس جريمة حرب.

تتمثل المشكلة الأخرى في النزعة السياسية البديهية إلى مطالبة الخبراء التكنولوجيين المتخصصين في وسائل التواصل الاجتماعي بـ "تصليح" مشاكل مثل الأخبار المزيفة أو خطاب الكراهية. تعمل الشركات بحسب النقرات والأرباح النقدية، لا التوازن الدقيق بين تعزيز حرية التعبير في المجتمعات الديمقراطية وحماية حقوق الآخرين. ستستخدم هذه الشركات الخوارزميات لتحديد حقوقنا، وليس الخبراء القانونيين المدرّبين جيدا. حتى لو تمكنت الشركات من شرح كيف تقوم آلاتها باتخاذ القرارات، لن تكشف أسرار اختراعاتها.

قد تخفف الشفافية من بعض مشاكل التحيّز؛ إذا استطعنا اختبار الخوارزميات أو تدقيق البيانات التي تتعلم منها، قد نتمكّن من تدارك الأخطاء والمشاكل. تترافق البيانات مع أحكام مسبقة عن العالم والفقر والظلم فيه، وقد تزيد البيانات المتحيّزة أو غير المكتملة من احتمال اتخاذ قرار منحاز، كما تبيّن من الأدوات التي تدّعي التنبؤ بالجرائم أو العودة إلى الإجرام أو الأهلية الائتمانية.

لكن لا يمكن للشفافية حل جميع المشاكل، حتى عندما يكون تحقيقها ممكنا. قد تكون قرارات الحكم الصادرة عن خوارزمية مدربة جيدا أكثر "عقلانية" من قرارات قاضٍ جائع أو غاضب أو لديه أحكام مسبقة، لكن قد تُهان كرامة الإنسان بمجرّد إعفاء القاضي من مسؤولية حرمانه شخصا آخر من الحرية لسنين. يتساوى الاستماع للمتهم والتعاطف معه والشفقة عليه والاستناد إلى التجربة الإنسانية التي يعيشها الإنسان، في الأهمية، مع احتساب المخاطر لإصدار حكم عادل والحفاظ على الكرامة الإنسانية. في بعض الأحيان، تتطلب معالجة الخطأ البشري أحيانا تحسين حكم الإنسان ومسؤوليته، لا التشجيع على التخلّي عن هذا الحكم أو تقزيمه.

تُعتبر أدوات تعلم الآلة— كحال أي تقنية— وسيلة، لا غاية. عندما تُستعمل لغرض جيد، يمكنها تعزيز المساءلة والحقوق. علينا الإصرار على أن تكون هذه الأدوات دائما تحت سيطرة البشر، وأن تُطبّق فقط حيثما ستعزز حقوق الإنسان وتكفل الانتصاف للانتهاكات وتضمن المسؤولية البشرية. إنه خيار مرتبط بالسياسات، ولا يمكن للروبوتات الخارقة المستقبلية اتخاذه.