Résumé

Dans les cas non prévus par le présent Protocole ou par d’autres accords internationaux, les personnes civiles et les combattants restent sous la sauvegarde et sous l’empire des principes du droit des gens, tels qu’ils résultent des usages établis, des principes de l’humanité et des exigences de la conscience publique.

— Clause de Martens, telle qu’énoncée dans le Protocole I aux Conventions de Genève de 1977

Les armes entièrement autonomes sont l’une des technologies militaires en cours de développement les plus inquiétantes. Il est urgent que les États, les spécialistes et le grand public examinent attentivement ces armes à la lumière de la clause de Martens, unique disposition du droit international humanitaire qui établisse une base de référence pour la protection des civils et des combattants lorsqu’une situation n’est couverte par aucun texte juridique. Le présent rapport montre comment les armes entièrement autonomes, qui seraient capables de sélectionner et d’attaquer des cibles sans contrôle humain significatif, iraient à l’encontre des deux piliers de la clause de Martens : les principes de l’humanité et les exigences de la conscience publique. Afin de respecter la clause de Martens, les États devraient adopter une interdiction préventive portant sur la mise au point, la production et l’utilisation de ces armes.

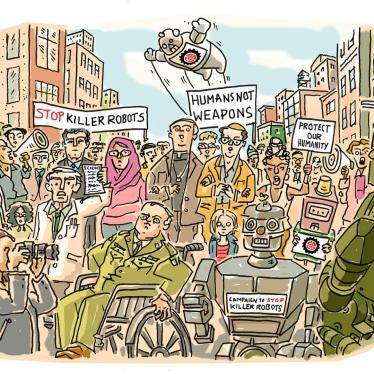

Au vu du développement rapide des technologies autonomes et de l’intelligence artificielle (IA), les armes entièrement autonomes pourraient devenir une réalité dans un futur proche. Également connues sous le nom de « robots tueurs » et de « systèmes d’armes létales autonomes », elles soulèvent une multitude de préoccupations en matière de morale, de droit, de responsabilité, de fonctionnement, de technique et de sécurité. Ces armes font l’objet de débats internationaux depuis 2013. Cette année-là, la Campagne contre les robots tueurs (Campaign to Stop Killer Robots), une coalition de la société civile, a été créée pour pousser les États à examiner la question de ces armes. Après avoir organisé trois réunions informelles d’experts, les États parties à la Convention sur certaines armes classiques (CCAC) a entamé, en 2017, des discussions formelles. En août 2018, environ 80 États doivent se réunir de nouveau à l’occasion d’une nouvelle rencontre du Groupe d’experts gouvernementaux de la CCAC.

L’examen des armes entièrement autonomes et de la voie à suivre mené par les États parties à la CCAC doit placer la clause de Martens au centre du débat. Cette clause, qui est commune au droit international humanitaire et aux traités sur le désarmement, dispose que, en l’absence d’accord international, les usages établis, les principes de l’humanité et les exigences de la conscience publique doivent apporter une protection aux civils et aux combattants. Elle s’applique aux armes entièrement autonomes car celles-ci ne sont pas spécifiquement couvertes par le droit international. Les experts ne sont pas tous d’accord sur la signification juridique précise de la clause de Martens ; pour certains, elle reprend le droit coutumier, pour d’autres elle constitue une source de droit indépendante, et pour d’autres encore elle sert d’outil d’interprétation. Il n’en reste pas moins que la clause de Martens fournit aux États des éléments essentiels à prendre en compte pour évaluer des technologies d’armement émergentes telles que les armes entièrement autonomes. Elle crée une norme morale permettant de juger ces armes.

Les principes de l’humanité

Du fait de leur absence d’émotions et de jugement juridique et éthique, les armes entièrement autonomes auraient beaucoup de mal à respecter les principes de l’humanité. Selon ces principes, il convient de traiter autrui avec humanité et de respecter la vie et la dignité humaines. Les êtres humains sont naturellement poussés à traiter leurs semblables avec humanité car ils ressentent de la compassion et de l’empathie à leur égard. Le jugement juridique et éthique offre, quant à lui, les moyens de limiter les maux infligés ; il permet de prendre des décisions réfléchies, fondées sur la compréhension d’un contexte particulier. En tant que machines, les armes entièrement autonomes ne seraient pas des êtres sensibles capables de ressentir de la compassion. Au lieu d’exercer un jugement, ces systèmes d’armes fonderaient leur action sur des algorithmes préprogrammés, qui ne fonctionnent pas bien dans des situations complexes et imprévisibles.

Respecter la vie humaine suppose de réduire le nombre de morts. Le jugement éthique et juridique aide l’être humain à évaluer différents facteurs pour éviter les morts arbitraires et injustifiées dans les conflits armés ou dans d’autres situations. Il serait complexe de recréer ce jugement, qui s’est développé au travers de l’histoire de l’être humain et de la vie de chacun, chez des armes entièrement autonomes. Elles ne pourraient pas non plus être préprogrammées pour traiter l’ensemble des scénarios possibles tout en respectant les normes juridiques et éthiques. En outre, la plupart des êtres humains éprouvent une aversion naturelle face à l’acte de tuer, parce qu’ils comprennent l’impact de la perte de la vie, ce que les armes entièrement autonomes, en tant que machines inanimées, ne peuvent connaître.

Même si les armes entièrement autonomes pouvaient protéger la vie humaine de manière adéquate, elles seraient incapables de respecter la dignité humaine. À la différence des êtres humains, ces robots ne seraient pas capables d’apprécier pleinement la valeur d’une vie humaine et la signification de sa perte. Elles fonderaient les décisions de vie ou de mort sur des algorithmes, réduisant leurs cibles humaines à des objets. Les armes entièrement autonomes violeraient de cette manière les principes de l’humanité sur tous les plans.

Les exigences de la conscience publique

L’indignation croissante de la population face aux armes entièrement autonomes laisse penser que cette nouvelle technologie va aussi à l’encontre du deuxième volet de la clause de Martens, les exigences de la conscience publique. Ces exigences sont un ensemble d’orientations morales, qui se fondent sur la connaissance de ce qui est bien ou mal. Elles peuvent être déterminées par l’intermédiaire de l’opinion publique et des avis du gouvernement.

Beaucoup de personnes, d’experts et de gouvernement se sont fortement opposés à la mise au point d’armes entièrement autonomes. La majorité des personnes interrogées dans le cadre d’une multitude de sondages d’opinion ont fait part de leur opposition à ces armes. Des experts, qui ont étudié la question de manière plus approfondie, ont publié des lettres ouvertes et des déclarations qui reflètent mieux la conscience que les sondages. Des organisations internationales et des organisations non gouvernementales (ONG), aux côtés de leaders dans les domaines du désarmement et des droits humains, de la paix et de la religion, de la science et de la technologie, et de l’industrie, se sont sentis contraints, en particulier pour des motifs en lien avec la morale, d’appeler à l’interdiction des armes entièrement autonomes. Pour eux, ces armes sont « inadmissibles », « un affront (…) au caractère sacré de la vie », « insensées » et « contraires à l’éthique ».

Les gouvernements ont cité le respect de la clause de Martens et les manquements sur le plan moral parmi les principales préoccupations soulevées par les armes entièrement autonomes. Au mois de juillet 2018, 26 États avaient apporté leur soutien à une interdiction préventive, et plus d’une centaine d’États avaient lancé un appel en faveur d’un instrument juridiquement contraignant afin de répondre aux préoccupations soulevées par les systèmes d’armes létales autonomes. Presque tous les États parties à la Convention sur certaines armes classiques qui sont intervenus lors de leur dernière réunion en date, en avril 2018, ont insisté sur la nécessité de conserver un contrôle humain sur le recours à la force. Ce consensus qui apparaît et qui équivaut, dans les faits, à interdire les armes qui ne requièrent pas d’intervention humaine significative, prouve que la conscience publique est fortement opposée aux armes entièrement autonomes.

La nécessité d’un traité d’interdiction préventive

Une évaluation des armes entièrement autonomes au regard de la clause Martens fait ressortir la nécessité d’une nouvelle loi spécifique et solide. Des règles qui ne feraient qu’encadrer leur utilisation ne suffiraient pas. Par exemple, le fait de limiter l’utilisation des armes à certains lieux n’empêcherait pas le risque de prolifération entre les mains d’acteurs n’ayant que peu d’égard pour le traitement d’autrui avec humanité ou la vie humaine et aucun respect pour la dignité des civils et des combattants. En outre, la conscience publique témoigne d’un large soutien en faveur d’une interdiction des armes entièrement autonomes, ou de son équivalent, à savoir l’obligation d’un contrôle humain significatif. Afin de garantir le respect des principes de l’humanité et des exigences de la conscience publique, les États devraient interdire de manière préventive la mise au point, la production et l’utilisation des armes entièrement autonomes.

Recommandations

Afin de prévenir les risques liés aux armes entièrement autonomes et à la perte de contrôle humain sur la sélection et l’attaque de cibles, qu’ils soient d’ordre juridique, moral ou autre, Human Rights Watch et International Human Rights Clinic (IHRC) de la faculté de droit de Harvard recommandent ce qui suit :

Aux États parties à la Convention sur certaines armes classiques

· Adopter, lors de leur réunion annuelle de novembre 2018, un mandat pour négocier un nouveau protocole interdisant les systèmes d’armes entièrement autonomes, ou systèmes d’armes létales autonomes, en vue d’une conclusion des négociations fin 2019.

· Profiter de la réunion du Groupe d’experts gouvernementaux en août 2018 pour présenter des positions nationales claires et parvenir à un accord sur la nécessité d’adopter un mandat de négociation lors de la réunion annuelle de novembre.

· Élaborer des positions et adopter des interdictions au niveau national, qui constitueront les éléments de base d’une interdiction au niveau international.

· Exprimer leur opposition aux armes entièrement autonomes, notamment pour des raisons juridiques et morales reflétées dans la clause de Martens, afin de développer encore davantage la conscience publique.

Aux experts du secteur privé

· S’opposer à la suppression d’un contrôle humain significatif sur les systèmes d’armes et sur le recours à la force.

· Exprimer publiquement un soutien explicite à l’appel à l’interdiction des armes entièrement autonomes, notamment pour des raisons juridiques et morales reflétées dans la clause de Martens, et appeler les gouvernements à entamer la négociation d’un nouveau traité international.

· S’engager à ne pas participer à la conception ou au développement de l’intelligence artificielle au service des armes entièrement autonomes au travers de codes de conduite, de déclarations de principe et d’autres mesures garantissant que le secteur privé ne prend pas part à la mise au point, à la production ou à l’utilisation de ces armes.

I. Contexte des armes entièrement autonomes

Les armes entièrement autonomes seraient capables de sélectionner et d’attaquer des cibles sans intervention humaine significative. Elles représentent une évolution inacceptable des drones armés actuels, car la décision finale de recourir à la force contre une personne ne serait pas prise par un humain. Les armes entièrement autonomes, également connues sous les appellations « systèmes d’armes létales autonomes » ou « robots tueurs », n’existent pas encore ; elles sont en cours de développement, et les investissements militaires dans les technologies autonomes augmentent de manière alarmante.

Les risques liés aux armes entièrement autonomes sont bien plus importants que leurs prétendus avantages. D’après les partisans de cette nouvelle technologie, celle-ci pourrait sauver la vie de soldats, traiter des données et agir avec plus de rapidité que les systèmes traditionnels, tout en restant insensible à la peur et à la colère, qui peuvent être à l’origine de la mort de civils. Les armes entièrement autonomes, cependant, soulèvent de nombreuses graves inquiétudes, dont la plupart ont été mises en avant par Human Rights Watch dans de précédentes publications. Premièrement, le fait de confier à des machines la décision de vie ou de mort franchit une ligne rouge sur le plan moral. Deuxièmement, les armes entièrement autonomes devraient relever des défis de taille pour être en conformité avec le droit international humanitaire et le droit international relatif aux droits humains. Troisièmement, elles créeraient un vide en matière de responsabilité, en raison de la difficulté de demander des comptes en cas de préjudices imprévus causés par un robot autonome. Quatrièmement, les armes entièrement autonomes seraient exposées au spoofing et au piratage. Cinquièmement, ces armes seraient une menace pour la sécurité mondiale, car elles pourraient engendrer une course à l’armement, être massivement employées par des acteurs n’ayant que peu de respect pour le droit international et augmenter la menace de guerre[1].

Le présent rapport s’intéresse à un autre sujet préoccupant, qui touche au droit et à la morale : le fait que les armes entièrement autonomes ne respecteraient vraisemblablement pas la clause de Martens. Cette clause du droit international humanitaire exige des États qu’ils prennent en considération les principes de l’humanité et les exigences de la conscience publique au moment d’examiner une nouvelle technique d’armement. Présente dans les Conventions de Genève et les traités de désarmement, elle contraint juridiquement les États à tenir compte de considérations morales.

Face aux multiples problèmes présentés par les armes entièrement autonomes, dont celui du non-respect de la clause de Martens, il est nécessaire d’agir sans attendre. Quelques États ont proposé d’adopter une position attentiste, car on ignore encore quelle technologie va pouvoir être générée. Cependant, au vu de l’importance des enjeux, il semble préférable d’adopter une approche préventive. L’incertitude scientifique ne devrait pas faire obstacle aux mesures visant à éviter ce que certains scientifiques ont qualifié de « troisième révolution de la guerre, après l’invention de la poudre à canon et des armes nucléaires »[2]. Les pays devraient adopter une interdiction à titre préventif du développement, de la production et de l’utilisation des armes entièrement autonomes.

II. Histoire de la clause de Martens

La clause de Martens trouve son origine dans un compromis diplomatique, et a servi des fins humanitaires. Elle établit que, en l’absence d’une disposition conventionnelle spécifique, les usages établis, les principes de l’humanité et les exigences de la conscience publique protègent les civils et les combattants. Depuis son introduction, la clause de Martens est devenue un élément commun des instruments fondateurs du droit international humanitaire. Elle est aussi reprise dans de nombreux traités de désarmement. Les protections offertes par la clause de Martens et la reconnaissance juridique dont elle jouit prouvent son importance pour l’examen de systèmes d’armes émergents qui pourraient avoir de lourdes répercussions humanitaires sur le champ de bataille et au-delà.

Origines de la clause de Martens

La clause de Martens est apparue pour la première fois dans le préambule de la Convention II de La Haye de 1899 contenant les lois et coutumes de la guerre sur terre. Elle est ainsi rédigée :

En attendant qu’un code plus complet des lois de la guerre puisse être édicté, les Hautes Parties contractantes jugent opportun de constater que, dans les cas non compris dans les dispositions réglementaires adoptées par elles, les populations et les belligérants restent sous la sauvegarde et sous l’empire des principes du droit des gens, tels qu’ils résultent des usages établis entre nations civilisées, des lois de l’humanité et des exigences de la conscience publique[3].

La clause prévoit donc un niveau de protection minimal pour les civils et les combattants en l’absence de dispositions réglementaires spécifiques.

Le diplomate et juriste russe Fyodor Fyodorovich Martens a proposé cette clause alors que les négociations se trouvaient dans une impasse lors de la Conférence de la paix réunie à La Haye en 1899, qui avait été organisée dans le but d’adopter des règles contraignantes applicables à la guerre, de réduire les dépenses consacrées à l’armement et de promouvoir la paix[4]. Les grandes puissances et les pays moins puissants ne parvenaient pas à se mettre d’accord sur le degré d’autorité que pouvait exercer une force occupante sur la population locale. Les grandes puissances insistaient pour élaborer un nouveau traité qui aurait précisé les droits et les obligations de toute force occupante, quand les pays moins puissants s’opposaient à la codification des dispositions d’une déclaration politique antérieure qui, selon eux, ne protégeaient pas les civils de manière adéquate. La clause de Martens offrait aux combattants ayant pris les armes contre une force occupante étrangère la possibilité d’affirmer que, si aucune disposition ne s’appliquait précisément à leur cas, ils étaient en droit de bénéficier de la protection prévue par les principes du droit international dérivés des usages, des « principes de l’humanité » et des « exigences de la conscience publique »[5].

Utilisation contemporaine de la clause de Martens

Au cours des quelque 120 années qui se sont écoulées depuis l’adoption de la Convention de La Haye de 1899, la clause de Martens a été appliquée plus largement et a peu à peu constitué le fondement des efforts visant à étendre la protection humanitaire lors des conflits armés. Aux fins de limiter les répercussions des hostilités, de nombreux instruments du droit international humanitaire et du droit du désarmement ont intégré cette disposition.

Conventions de Genève et Protocole additionnel I

Lors de l’élaboration des Conventions de Genève de 1949, piliers du droit international humanitaire[6], les négociations avaient pour but de garantir que certaines protections restent applicables en cas de retrait d’un État partie de l’un quelconque des traités. Les quatre Conventions de Genève contiennent la clause de Martens dans leurs articles sur la dénonciation, qui traitent des conséquences du retrait de la communauté des États participant aux conventions[7]. Le Comité international de la Croix-Rouge (CICR), gardien du droit international humanitaire, explique dans ses commentaires des conventions qui font autorité :

Si une Haute Partie contractante venait à dénoncer l’une des Conventions de Genève, elle serait toujours liée non seulement par l’intermédiaire d’autres traités auxquels elle reste partie, mais également par d’autres règles du droit international, telles que le droit coutumier. Un argumentum e contrario, qui laisse supposer l’existence d’un vide juridique à la suite de la dénonciation d’un texte conventionnel, est donc impossible[8].

Le Protocole additionnel I, adopté en 1977, élargit les protections prévues pour les civils par la Convention IV de Genève[9]. Ce protocole contient la formulation contemporaine de la clause de Martens, qui est également utilisée dans le présent rapport :

Dans les cas non prévus par le présent Protocole ou par d’autres accords internationaux, les personnes civiles et les combattants restent sous la sauvegarde et sous l’empire des principes du droit des gens, tels qu’ils résultent des usages établis, des principes de l’humanité et des exigences de la conscience publique[10].

En intégrant cette formulation dans son article « Principes généraux et champ d’application », plutôt qu’en en faisant une simple disposition relative à la dénonciation, le Protocole additionnel I élargit le champ d’application de la clause de Martens. D’après le commentaire du CICR :

S’il a paru utile de reprendre une nouvelle fois cette formule dans le Protocole, c’était à deux fins. D’abord (…) il n’est pas possible d’envisager qu’une codification soit complète à un moment quelconque ; la clause de Martens empêche ainsi de considérer que tout ce qui n’est pas expressément interdit par les traités pertinents est autorisé. Ensuite, on doit y voir un élément dynamique proclamant l’applicabilité des principes mentionnés nonobstant l’évolution ultérieure des situations ou de la technique.[11]

La clause de Martens comble ainsi un vide juridique du droit applicable et promeut la protection des civils face à des situations et des technologies nouvelles.

Traités de désarmement

Depuis 1925, la plupart des traités qui contiennent des dispositions interdisant des armes incluent également la clause de Martens[12]. Cette clause figure sous différentes formes dans les préambules du Protocole de Genève de 1925[13], la Convention sur les armes biologiques de 1972[14], la Convention sur certaines armes classiques de 1980[15], la Convention sur l’interdiction des mines de 1997[16], la Convention sur les armes à sous-munitions de 2008[17], et le Traité sur l’interdiction des armes nucléaires de 2017[18]. Même si le préambule n’établit pas de règles contraignantes, il peut servir à l’interprétation d’un traité et est généralement utilisé pour intégrer, par renvoi, le contexte réglementaire déjà existant. L’inclusion de la clause de Martens indique que, si les dispositions d’un traité présentent des lacunes, celles-ci doivent être comblées par les usages établis, les principes de l’humanité et les exigences de la conscience publique. En intégrant la clause de Martens dans cette série de traités sur le désarmement, les États ont réaffirmé son importance pour le droit international humanitaire en général et pour le droit relatif à l’armement plus particulièrement.

Parce que son emploi est généralisé, il est pertinent d’inclure la clause de Martens dans les discussions actuelles sur les armes entièrement autonomes. Cette clause fournit un principe permettant de garantir que les civils et les combattants bénéficient de protections minimales face à ces armes problématiques. En outre, la plupart des discussions diplomatiques relatives aux armes entièrement autonomes ont eu lieu sous les auspices de la Convention sur certaines armes classiques, qui inclut la clause de Martens dans son préambule. C’est pourquoi une évaluation des armes entièrement autonomes au regard de la clause de Martens devrait occuper une place centrale dans les délibérations relatives à une nouvelle convention sur les armes classiques.

III. Applicabilité et importance de la clause de Martens

La clause de Martens s’applique lorsqu’un sujet n’est pas couvert par un texte juridique particulier. Les experts ont des avis divergents sur son importance juridique ; néanmoins, elle donne des éléments que les États doivent prendre en considération dans l’étude des nouveaux défis des techniques émergentes. Son importance, en particulier pour le droit relatif au désarmement, est évidente dans les négociations qui ont mené à l’adoption de l’interdiction préventive des lasers aveuglants. Les États, entre autres, devraient par conséquent tenir compte de la clause de Martens dans les discussions relatives au caractère légal des armes entièrement autonomes et à la manière dont ce sujet doit être traité.

Applicabilité de la clause de Martens

La clause de Martens, telle qu’énoncée dans le Protocole additionnel I, s’applique « [d]ans les cas non prévus par le présent Protocole ou par d’autres accords internationaux » [19]. Même en faisant preuve de la plus grande prudence, les rédacteurs de traités ne peuvent pas prévoir toutes les circonstances possibles dans un instrument unique. La clause de Martens joue le rôle de mesure palliative en évitant qu’une situation qui n’avait pas été envisagée ou une technologie émergente ne bouleverse l’objectif global du droit humanitaire simplement parce qu’elle n’est couverte par aucune disposition conventionnelle[20].

La clause de Martens s’applique lorsque le droit des traités ne prévoit pas spécifiquement une situation donnée. Comme l’expliquait le tribunal militaire des États-Unis à Nuremberg, avec la clause de Martens, « les usages établis entre nations civilisées, les lois de l’humanité et les exigences de la conscience publique prennent le statut de références du droit, qui devront être appliquées lorsque les dispositions spécifiques [du droit existant] ne couvrent pas les cas précis pouvant se produire en temps de guerre[21] ». Elle est particulièrement pertinente dans le cas d’une nouvelle technologie que les rédacteurs des textes juridiques en vigueur n’auraient pas envisagée. La Cour internationale de Justice a affirmé que le fait que la clause « continu[ait] à exister et à être applicable ne [faisait] aucun doute » et qu’elle avait « prouvé qu’elle constituait un moyen efficace de contrer l’évolution rapide de la technologie militaire »[22]. Face au vide juridique en la matière, la clause de Martens sert de principe pour les nouvelles armes.

Parce qu’il s’agit d’une technologie qui connaît un développement rapide, les armes entièrement autonomes sont un exemple de cas dans lequel la clause de Martens peut s’appliquer. Le droit international humanitaire actuel ne s’applique aux armes entièrement autonomes que de manière générale. Il exige que toutes les armes respectent les principes fondamentaux de distinction et de proportionnalité, mais ne prévoit aucune disposition précise relative aux armes entièrement autonomes[23]. Les rédacteurs des Conventions de Genève n’auraient pas pu envisager la perspective d’un robot capable de déterminer de manière indépendante quand avoir recours à la force sans une intervention humaine significative. Puisque les armes entièrement autonomes représentent un cas non prévu par les textes juridiques en vigueur, elles devraient être examinées selon les principes formulés dans la clause de Martens.

Importance juridique de la clause de Martens

Il existe différentes interprétations de l’importance juridique de la clause de Martens[24]. Certains experts adoptent une perspective étroite, en affirmant que la clause de Martens ne sert qu’à rappeler que, si un traité n’interdit pas de manière explicite une action précise, cette action n’est pas automatiquement autorisée. En d’autres termes, les États devraient s’en remettre au droit international coutumier lorsque les textes conventionnels ne prévoient pas un cas particulier[25]. Cette opinion est assurément insatisfaisante, cependant, car elle ne porte que sur un aspect de la clause, les usages établis, et néglige le rôle des lois de l’humanité et des exigences de la conscience publique. Selon les règles convenues de l’interprétation juridique, une clause devrait être lue de manière à donner une signification à chaque terme[26]. Considérer que les principes de l’humanité et les exigences de la conscience publique sont simplement des éléments des usages établis les rendrait redondants et irait à l’encontre de ces règles.

Pour d’autres, la clause de Martens est en elle-même une source unique de droit[27]. Ils soutiennent que les termes clairs de la clause de Martens font des lois de l’humanité et des exigences de la conscience publique des principes juridiques indépendants permettant d’évaluer les situations non prévues et les nouvelles formes de technologie militaire[28]. Ainsi, une situation ou une arme qui ne respecte pas l’un ou l’autre de ces principes est intrinsèquement contraire à la loi.

Antonio Cassese, juriste en droit international public, a adopté une approche intermédiaire en considérant les principes de l’humanité et les exigences de la conscience publique comme des « orientations fondamentales » pour l’interprétation du droit international[29]. Comme l’a écrit M. Cassese, « [e]n cas de doute, les règles internationales, en particulier les règles du droit humanitaire, doivent être interprétées de manière à se trouver en accord avec les principes généraux de l’humanité et les exigences de la conscience publique »[30]. Ainsi, on ne devrait pas considérer que le droit international cautionne des situations ou des technologies qui suscitent des inquiétudes au regard de ces aspects de la clause de Martens.

Au minimum, la clause de Martens donne des éléments que les États doivent prendre en considération dans leur manière d’appréhender les techniques d’armement émergentes, dont font partie les armes entièrement autonomes. En 2018, le CICR a reconnu « le débat visant à déterminer si la clause de Martens constitue un critère juridiquement contraignant à l’égard duquel le caractère légal d’une arme doit être évalué, ou du moins une orientation éthique »[31] . Le CICR a conclu, cependant, qu’il « apparaît clairement que les considérations d’humanité et de conscience publique ont orienté l’évolution du droit international en matière d’armement, et que ces notions ont déclenché la négociation de traités particuliers destinés à interdire ou à limiter certaines armes »[32]. Lorsque des inquiétudes relatives à une arme naissent au regard des principes de l’humanité ou des exigences de la conscience publique, le fait d’adopter un texte juridique nouveau et plus précis, qui élimine les doutes sur la licéité d’une arme, peut permettre de renforcer les protections prévues pour les civils et les combattants.

La clause de Martens donne également une valeur juridique à des considérations morales. Codifiée dans les textes conventionnels internationaux, elle requiert néanmoins d’évaluer une situation ou une technologie au regard des principes de l’humanité et des exigences de la conscience publique, qui intègrent toutes deux des éléments moraux. Peter Asaro, philosophe dans le domaine de la science et des technologies, a écrit que la clause de Martens invite à « avoir une réflexion morale sur le rôle des principes de l’humanité et les exigences de la conscience publique lors de l’élaboration et de la mise en place de nouveaux [textes de droit international humanitaire] »[33]. Si l’évaluation morale des armes entièrement autonomes est intrinsèquement importante, la clause de Martens en fait une obligation juridique lorsqu’aucune disposition règlementaire n’existe.

Le précédent de l’interdiction préventive des lasers aveuglants

La clause de Martens a été invoquée par des États, des organisations internationales et la société civile lors de précédentes délibérations concernant une technologie émergente et pour laquelle aucune réglementation n’existait[34],particulièrement dans les années 90 à l’occasion des discussions concernant les lasers aveuglants. Ils renvoyaient, de manière explicite et implicite, aux éléments de la clause de Martens afin de justifier l’interdiction préventive des lasers aveuglants. Le Protocole IV de la Convention sur certaines armes classiques, adopté en 1995, établit l’interdiction[35].

Au cours d’une table ronde organisée par le CICR en 1991, des experts ont souligné la pertinence de la clause de Martens. D’après Louise Doswald-Beck, juriste au CICR, les « décisions d’imposer des restrictions spécifiques à l’usage de certaines armes peuvent se fonder sur des considérations politiques » et « les critères inscrits dans la clause de Martens [devraient] être particulièrement pris en considération »[36]. Pour un autre participant, « la clause de Martens aborde en particulier le problème de la souffrance humaine de manière à ce que la "conscience publique" fasse référence à ce qui est considéré comme inhumain ou socialement inacceptable »[37].

Les propos des détracteurs des lasers aveuglants ont prouvé que ces armes soulevaient des inquiétudes relatives aux principes de l’humanité et aux exigences de la conscience publique. Lors de réunions organisées par le CICR, plusieurs intervenants ont estimé que « les armes conçues pour aveugler sont (…) socialement inacceptables »[38]. Le CICR lui-même a lancé un appel à « la conscience de l’humanité » dans son plaidoyer pour leur interdiction[39]. Lors de la première Conférence d’examen de la Convention sur certaines armes classiques, des représentants d’agences de l’ONU et de la société civile ont décrit les lasers aveuglants comme « barbares »[40], « aberrants pour la conscience de l’humanité »[41] et « inacceptables dans le monde moderne »[42]. Une campagne de sensibilisation particulièrement efficace menée par le CICR montrait des photographies de soldats aveuglés par du gaz toxique au cours de la Première guerre mondiale afin de démontrer que le fait de rendre définitivement aveugles des soldats est cruel et inhumain.

C’est grâce à ce type de caractérisation que le besoin d’une interdiction préventive a été associée aux lasers aveuglants. Par exemple, au cours des débats de la première Conférence d’examen, le Chili a dit avoir « l’espoir que la Conférence d’examen parviendra à établir des principes directeurs concernant les mesures de prévention à prendre pour empêcher la mise au point de moyens techniques barbares et éviter ainsi de devoir remédier aux souffrances que ces moyens risquent d’infliger »[43]. Dans une résolution de décembre 1995 exhortant les États à ratifier le Protocole IV, le Parlement européen a déclaré que « faire la guerre en utilisant délibérément des armes aveuglantes est une pratique aberrante »[44]. Reprenant les termes de la clause de Martens, le Parlement européen a affirmé que « faire la guerre en utilisant délibérément des armes aveuglantes est (…) contraire aux us et coutumes en la matière, aux principes d’humanité et à la voix de la conscience publique »[45]. Le CICR a qualifié le Protocole IV de « succès de la civilisation sur la barbarie »[46].

Les discussions relatives au Protocole IV de la Convention sur certaines armes classiques soulignent la pertinence de la clause de Martens dans le débat actuel portant sur les armes entièrement autonomes. Elles prouvent que, au cours de l’histoire, les États parties de la Convention sur certaines armes classiques ont appliqué la clause de Martens à des armes qui suscitaient la controverse. Elles montrent aussi la volonté de ces États d’interdire à titre préventif une arme qu’ils considèrent comme allant à l’encontre des principes de l’humanité et des exigences de la conscience publique. Comme cela sera développé plus loin, les armes entièrement autonomes soulèvent de graves inquiétudes au regard de la clause de Martens. Le fait que leur impact sur les conflits armés serait infiniment plus important que celui des lasers aveuglants devrait à lui seul suffire à montrer l’urgence de combler les lacunes du droit international et aboutir à une interdiction explicite de ces armes[47].

IV. Les principes de l’humanité

La clause de Martens divise les principes du droit international (« droit des gens » dans le texte original) en usages établis, lois de l’humanité et exigences de la conscience publique. Étant donné que le droit coutumier s’applique même sans cette clause, le présent rapport examine la question des armes entièrement autonomes à la lumière des deux derniers éléments. La clause de Martens ne définit pas ces termes, mais ils ont fait l’objet de nombreux débats dans les sphères académique et juridique.

La documentation pertinente explique les deux principales composantes des principes de l’humanité (« lois de l’humanité » dans le texte original). Les acteurs doivent : 1) traiter autrui avec humanité et 2) respecter la vie et la dignité humaines. Du fait de leur absence d’émotions et de jugement, les armes entièrement autonomes auraient beaucoup de mal à respecter ces deux contraintes.

Traitement humain

Définition

Le premier principe des lois de l’humanité consiste à traiter autrui avec humanité. Le dictionnaire Oxford définit l’humanité comme « le caractère de ce qui est humain ; bienveillance »[48]. L’obligation de faire preuve d’humanité envers autrui est une composante essentielle du droit international humanitaire et du droit international des droits humains[49]. Elle apparaît, par exemple, dans l’article 3 commun et d’autres dispositions des Conventions de Genève, dans de nombreux manuels militaires, dans la jurisprudence internationale et dans le Pacte international relatif aux droits civils et politiques[50]. La clause de Martens va plus loin que ces sources en disposant que les êtres humains doivent être traités avec humanité, même en l’absence de dispositions réglementaires spécifiques[51].

Pour pouvoir traiter d’autres êtres humains avec humanité, il faut faire preuve de compassion et exercer un jugement juridique et éthique[52]. La compassion, selon les principes fondamentaux du CICR, est un « mouvement de l’âme qui nous rend sensible aux maux d’autrui »[53]. Pour faire preuve de compassion, un acteur doit être capable de ressentir de l’empathie, c’est-à-dire de comprendre et de partager les sentiments d’autrui, et se sentir poussé à réagir[54]. Cette capacité émotionnelle est vitale dans des situations où la décision de recourir ou non à la force est prise[55]. Elle amène les acteurs à faire un effort conscient pour limiter les maux physiques et psychologiques causés à autrui. Agir avec compassion repose sur le postulat que « capturer son ennemi vaut mieux que le blesser, et le blesser vaut mieux que le tuer ; que les non-combattants doivent autant que possible être épargnés ; que les blessures infligées doivent être aussi légères que possible, afin que les blessés puissent être soignés et guéris, et qu’elles causent le moins de douleur possible »[56].

Alors que la compassion donne une motivation pour agir avec humanité, le jugement juridique et éthique offre un moyen de le faire. Pour agir avec humanité, un acteur doit prendre des décisions réfléchies quant à la manière de causer le moins de mal possible[57]. De telles décisions sont fondées sur la capacité de percevoir et de comprendre son environnement, et d’appliquer « le bon sens et la connaissance du monde » à des circonstances particulières[58]. Le professeur de philosophie James Moor fait remarquer que les acteurs doivent posséder la capacité « d’identifier et d’intégrer des informations éthiques dans des situations diverses et déterminer de manière sensible ce qu’il convient de faire dans ces situations » [59]. Ainsi, le jugement juridique et éthique aide un acteur à évaluer des facteurs pertinents pour s’assurer que les actes correspondent aux critères exigés par la compassion. Le jugement est essentiel pour limiter la souffrance : on ne peut se retenir de causer de la souffrance humaine que si l’on reconnaît les maux possibles et si l’on sait comment réagir[60].

Application aux armes entièrement autonomes

Les armes entièrement autonomes auraient beaucoup de mal à respecter le principe de traitement humain, car la compassion et le jugement juridique et éthique sont des facultés humaines. L’empathie, et la compassion qu’elle engendre vis-à-vis d’autrui sont naturelles pour les humains. La plupart des êtres humains connaissent la douleur physique ou psychologique, ce qui les pousse à éviter d’infliger des souffrances inutiles à leurs semblables. Leurs émotions transcendent les clivages, nationaux ou autres. Comme le constate le CICR, « les sentiments et les gestes de solidarité, de compassion, d’altruisme, sont répandus dans les cultures les plus diverses » [61]. La compréhension de la douleur et de la souffrance que partagent les êtres humains les pousse à faire preuve de compassion vis-à-vis de leurs semblables et leur inspire une réciprocité qui est, selon les mots du CICR, « tout[e] naturel[le] » [62].

Même l’arme entièrement autonome la plus perfectionnée qui soit ne pourrait pas ressentir d’émotions[63]. Il y a des avantages à ne pas ressentir d’émotions telles que la colère ou la peur, mais l’incapacité d’un robot à ressentir de l’empathie ou de la compassion limiterait gravement sa capacité à traiter une personne avec humanité. Parce qu’elles ne seraient pas des êtres sensibles, les armes entièrement autonomes ne pourraient pas connaître la souffrance physique ou psychologique. Par conséquent, elles n’auraient pas l’expérience et la compréhension que partagent les êtres humains et qui leur font ressentir, par l’empathie, la douleur des autres, qui les émeut et les pousse à faire preuve de compassion envers autrui. Amanda Sharkey, professeur d’informatique, a écrit : « Les robots actuels, n’ayant pas de corps vivant, ne peuvent ressentir la douleur ou s’inquiéter de leur propre état, sans parler de celui d’autrui. Comment peut-on ressentir de l’empathie vis-à-vis de la douleur ou de la détresse humaines si on est incapable de ressentir l’une ou l’autre de ces émotions ? » [64] Les armes entièrement autonomes seraient donc confrontées à de grandes difficultés si elles devaient veiller à ce que leurs actes soient empreints d’humanité et conformes aux principes de l’humanité.

Les robots n’auraient pas non plus la capacité de jugement juridique et éthique nécessaire pour limiter les souffrances au cas par cas[65]. Les situations impliquant le recours à la force, en particulier dans le cadre d’un conflit armé, sont souvent complexes et imprévisibles et peuvent changer rapidement. Les armes entièrement autonomes rencontreraient donc des difficultés importantes pour prendre les bonnes décisions en ce qui concerne le traitement humain. En analysant plusieurs études dans lesquelles des chercheurs avaient tenté de programmer un jugement éthique chez des robots, Amanda Sharkey a constaté que les robots ayant un comportement pouvant être qualifié « d’éthique » ou de « faiblement éthique » ne pouvaient fonctionner que dans un environnement contraint. Selon ses conclusions, les robots ont des capacités morales limitées et, par conséquent, ne devraient pas être utilisés dans des circonstances qui « exigent des compétences morales et une compréhension de la situation sociale environnante » [66]. Respecter le droit international nécessite souvent de prendre des décisions subjectives dans des situations complexes. Les armes entièrement autonomes auraient une aptitude limitée à interpréter les nuances du comportement humain, à comprendre les dynamiques politiques, socioéconomiques et environnementales de la situation et à appréhender les risques humanitaires liés à l’usage de la force dans un contexte particulier[67]. Ces limites compromettraient la capacité des armes à faire en sorte que les civils et les combattants soient traités avec humanité et à respecter le premier principe de l’humanité.

Respect de la vie et de la dignité humaine

Définition

Un deuxième principe de l’humanité exige des acteurs qu’ils respectent la vie et la dignité humaines. Christof Heyns, ancien Rapporteur spécial des Nations Unies sur les exécutions extrajudiciaires, sommaires ou arbitraires, a mis en avant ces concepts liés mais bien distincts en posant deux questions à propos des armes entièrement autonomes : « Peuvent-elles cibler de manière exacte ou rendre possible un ciblage exact ? » Et « Même si elles sont capables de cibler de manière appropriée, les machines devraient-elles avoir le pouvoir de vie ou de mort sur des humains »[68] ? La première question porte sur la conformité d’une arme avec les règles du droit international relatives à la protection de la vie. La seconde porte sur la « manière de cibler » et sur son respect de la dignité humaine[69].

Afin de respecter la vie humaine, les acteurs doivent prendre des mesures visant à limiter le nombre de personnes tuées[70]. Le droit à la vie établit que « Nul ne peut être arbitrairement privé de la vie »[71]. Il limite l’usage de la force létale à des circonstances dans lesquelles celui-ci est absolument nécessaire afin de protéger la vie humaine, constitue un dernier recours et est appliqué de manière proportionnée par rapport à la menace[72]. Codifié dans l’article 6 du Pacte international relatif aux droits civils et politiques, le droit à la vie a été reconnu comme un « droit suprême » du droit international humanitaire, qui s’applique dans toutes les circonstances. Lors des conflits armés, le droit international humanitaire détermine le caractère arbitraire ou injustifié de la privation de la vie. Pour cela, les acteurs doivent respecter les règles de distinction, de proportionnalité et de nécessité militaire dans les situations de conflit armé[73].

Le jugement et l’émotion sont deux éléments qui favorisent le respect de la vie, car ils peuvent agir comme des freins à la décision de tuer. La capacité de formuler des jugements juridiques et éthiques peut aider un acteur à déterminer quelle action permettra de mieux protéger la vie humaine dans le nombre infini de scénarios possibles qui n’auront pas été envisagés. Une résistance instinctive à l’acte de tuer donne une motivation psychologique qui pousse à respecter, voire parfois à aller au-delà des règles du droit international dans le but de réduire le nombre de tués.

Au nom des lois de l’humanité, les acteurs doivent également respecter la dignité de tous les êtres humains. Cette obligation se fonde sur la reconnaissance que chaque être humain possède une valeur intrinsèque à la fois universelle et inviolable[74]. Nombre d’instruments, parmi lesquels la Déclaration universelle des droits de l’homme, le Pacte international relatif aux droits civils et politiques, la Déclaration et le Programme d’action de Vienne adoptés en 1993 lors de la Conférence mondiale de 1993 sur les droits de l’homme, ainsi que des traités régionaux, consacrent l’importance de la dignité en en faisant un principe fondateur du droit relatif aux droits de l’homme[75].La Charte africaine des droits de l’homme et des peuples établit clairement que les personnes ont « droit au respect de la dignité inhérente à la personne humaine »[76].

Si le respect de la vie humaine suppose de réduire le nombre de personnes tuées et d’éviter toute mort arbitraire ou injustifiée, le respect de la dignité humaine exige d’apprécier la gravité de la décision de donner la mort[77]. Le CICR a expliqué que ce qui importe n’est « pas uniquement le fait qu’une personne soit tuée ou blessée, mais également la manière dont elle est tuée ou blessée, tout comme le processus au cours duquel ces décisions sont prises »[78]. Avant de mettre fin à une vie humaine, un acteur doit pleinement comprendre la valeur de celle-ci et la signification de sa perte. Les êtres humains devraient être reconnus en tant que personnes uniques et ne pas être réduits à des objets ayant une valeur uniquement instrumentale, voire nulle[79]. Lorsqu’un acteur tue sans prendre en compte la valeur de la victime en tant que personne, sa mise à mort fragilise la notion fondamentale de la dignité humaine et viole ce principe de l’humanité.

Application aux armes entièrement autonomes

Il semble peu probable que les armes entièrement autonomes soient en mesure de respecter la vie humaine et la dignité humaine. Leur absence de jugement juridique et éthique irait à l’encontre de leur capacité à respecter la vie humaine. Ainsi, le test de proportionnalité du droit international humanitaire exige des commandants qu’ils déterminent, au cas par cas, si l’avantage militaire attendu est supérieur aux dommages que la population civile aurait à subir. Au vu de l’infinité de situations qui peuvent survenir sur le champ de bataille, les armes entièrement autonomes ne pourraient pas être préprogrammées pour procéder à une telle appréciation. Le principe généralement admis pour évaluer la proportionnalité consiste à déterminer si « un commandant militaire raisonnable » aurait lancé une attaque donnée[80] ; or, pour prendre une décision raisonnable, il est nécessaire de se fonder sur des considérations éthiques et juridiques[81]. Parce qu’elles ne seraient pas capables d’appliquer ce principe au test de proportionnalité, les armes entièrement autonomes mettraient sans doute en danger les civils et pourraient violer les dispositions du droit international humanitaire[82].

Les armes entièrement autonomes n’auraient pas non plus l’aversion instinctive de l’humain face à l’acte de tuer, qui peut protéger la vie humaine au-delà de ce qu’exige le droit[83]. Cette propension à éviter de tuer est naturelle chez la plupart des êtres humains, qui apprécient la valeur intrinsèque de la vie humaine de manière innée. Des recherches théoriques montrent la réticence de l’être humain à prendre la vie d’un semblable. Ainsi, un Ranger de l’armée des États-Unis à la retraite a conduit de vastes recherches sur l’acte de donner la mort lors d’un conflit armé et a conclu que « l’homme porte en lui une grande aversion pour le fait de tuer son semblable. Cette aversion est si forte que, dans de nombreux cas, les soldats sur le champ de bataille mourront avant d’avoir pu la surmonter »[84]. En tant qu’objets inanimés, les armes entièrement autonomes ne risqueraient pas de perdre la vie ou de comprendre les émotions liées à la perte d’un être cher. Il est permis de douter qu’un programmeur puisse reproduire chez un robot la tendance naturelle d’un être humain à éviter de donner la mort et à protéger la vie avec la complexité et les nuances qui interviennent lors de la prise d’une décision par un être humain.

Les armes entièrement autonomes ne pourraient pas respecter la dignité humaine, qui est liée au processus et non aux conséquences du recours à la force[85]. En tant que machines, elles ne pourraient pleinement appréhender la valeur de la vie d’une personne ou la signification de sa perte. Elles baseraient la décision de tuer sur des algorithmes, sans prendre en compte l’humanité d’une victime donnée[86]. En outre, ces armes seraient programmées à l’avance selon un certain scénario et ne pourraient pas répondre de la nécessité de la force létale dans une situation particulière. Christof Heyns, dans une présentation relative à la Convention sur certaines armes classiques faite en tant que rapporteur spécial, a expliqué ce qui suit :

[P]ermettre aux machines de déterminer quand et où utiliser la force contre des humains, c’est réduire les humains à des objets ; ils sont traités comme de simples cibles. Ils deviennent des zéros et des uns dans l’objectif numérique d’armes programmées à l’avance pour faire usage de la force sans qu’elles soient en mesure d’envisager un autre moyen, ni qu’elles aient un niveau de réflexion suffisant semblable à celui utilisé par l’être humain pour faire un choix délibéré[87].

De la même manière, Mines Action Canada a conclu que « le fait de déployer [des armes entièrement autonomes] pendant le combat indique que l’on considère que tout être humain ciblé de cette manière ne justifie pas la considération d’un opérateur humain, ce qui revient à priver cette vie humaine de son droit à la dignité »[88]. Permettre à un robot de prendre une vie humaine alors qu’il ne peut pas comprendre la valeur intrinsèque de celle-ci ni la nécessité de la prendre est une preuve de non-respect et de dénigrement de la personne. Cela va à l’encontre des lois de l’humanité inscrites dans la clause de Martens.

Lorsqu’elle est employée dans des situations appropriées, l’intelligence artificielle peut avoir des retombées extraordinaires pour l’humanité. Laisser des robots prendre la décision de tuer des humains, cependant, serait contraire à la clause de Martens, qui combine droit et morale. Les capacités limitées de ces machines sur le plan des émotions, de la perception et de l’éthique entravent lourdement leur capacité à traiter les êtres humains avec humanité et à respecter la vie et la dignité humaines. Par conséquent, le recours à ces armes serait incompatible avec les lois de l’humanité, telles qu’établies dans la clause de Martens.

V. Les exigences de la conscience publique

La clause de Martens établit que, en l’absence de texte conventionnel applicable, les exigences de la conscience publique protègent, avec les principes de l’humanité, les civils et les combattants. Le renvoi à la « conscience publique » introduit un élément de moralité dans le droit et exige que l’évaluation des moyens et des méthodes de guerre prennent en considération les opinions des citoyens et des experts, ainsi que celui des gouvernements. La réaction de ces protagonistes à la perspective des armes entièrement autonomes montre clairement que la mise au point, la production et l’utilisation d’une telle technologie soulèverait de graves préoccupations au regard de la clause de Martens.

Définition

La notion d’« exigences de la conscience publique » fait référence aux orientations morales communes qui définissent les actions des États et des personnes[89]. L’utilisation du terme « conscience » montre que les exigences se fondent sur un sentiment de moralité, une connaissance de ce qui est bien ou mal[90]. Selon le philosophe Peter Asaro, la conscience implique de « se sentir contraint par, ou de croire en un devoir ou une obligation morale »[91]. L’adjectif « publique » précise que ces exigences reflètent les préoccupations d’un ensemble de personnes et d’entités. Le présent rapport s’appuie sur le travail souvent cité du juriste et expert du droit international humanitaire Theodor Meron pour analyser deux sources en particulier, afin de déterminer ce qui constitue la conscience publique : l’opinion du public et les opinions des gouvernements[92].

Les données issues de sondages et les avis d’experts donnent un aperçu de l’opinion du public[93]. Les études révèlent les points de vue et les croyances d’individus lambda. Elles peuvent aussi mettre en lumière différentes nuances dans les valeurs et les conceptions des personnes laïques. Les sondages, même s’ils sont informatifs, ne donnent pas une mesure satisfaisante de la conscience publique, car les réponses, qui peuvent être influencées par la nature de la question, ne reflètent pas nécessairement les considérations morales[94]. Les déclarations et les initiatives d’experts, qui donnent souvent naissance à de longs débats sur la question concernée, sont le reflet d’une assimilation plus poussée[95]. Les experts se spécialisent dans des domaines spécifiques, de la religion à la technologie en passant par le droit ; ils partagent néanmoins une connaissance approfondie du sujet. Les opinions qu’ils formulent peuvent donc faire la lumière sur les normes morales adoptées par un public averti[96].

Le gouvernement exprime sa position au travers de politiques et de déclarations écrites ou orales présentées lors de réunions diplomatiques et dans le débat public. Cette position est propre à la vision nationale en matière de développement économique, de prouesses militaires, de systèmes politiques, de traditions religieuses et culturelles et de démographie, et varie selon les pays. L’opinion du gouvernement peut aider à montrer l’opinio juris, un élément du droit international coutumier qui désigne la conviction d’un État qu’une pratique donnée est juridiquement obligatoire[97].

Application aux armes entièrement autonomes

Les opinions exprimées par les individus et les gouvernements partout dans le monde ont prouvé que les armes entièrement autonomes posent de graves problèmes au regard de la conscience publique. Grâce à des sondages d’opinion, des lettres ouvertes, des déclarations orales et écrites, des publications étayées et des lignes directrices auto-imposées, le grand public a partagé son anxiété et son indignation face à la perspective de ces armes. Des membres du gouvernement de plus d’une centaine de pays ont fait part de préoccupations similaires et se sont exprimés en faveur de l’application de limites aux armes entièrement autonomes[98]. Même si l’opposition du grand public aux armes entièrement autonomes n’est pas universelle, ces voix peuvent, collectivement, montrer qu’elle est à la fois massive et grandissante[99].

Opinion du grand public

L’opposition du grand public à la mise au point, la production et l’utilisation des armes entièrement autonomes est importante et grandissante. Plusieurs sondages d’opinion menés auprès de la population ont montré la résistance exprimée face à ces armes[100]. Ces conclusions se retrouvent dans des déclarations faites par des leaders dans plusieurs domaines pertinents comme le désarmement et les droits humains, la paix et la religion, la science et la technologie, et l’industrie. Même si elles ne sont pas exhaustives, les sources dont il est question ci-dessous illustrent la nature et la variété d’opinions et sont la preuve de l’existence d’une conscience publique.

Sondages d’opinion

Des sondages d’opinion conduits auprès du grand public dans le monde entier ont documenté l’opposition massive à la mise au point, à la production et à l’utilisation de ces armes. D’après ces sondages, la majorité des personnes interrogées ont considéré comme « inacceptable » la perspective de déléguer des décisions de vie ou de mort à des machines. Ainsi, une étude menée en 2013 par le professeur de sciences politiques Charli Carpenter auprès de citoyens américains a conclu que 55 pour cent des personnes interrogées étaient opposées à la « tendance en faveur de l’utilisation » d’armes entièrement autonomes[101]. Cette opinion était partagée de manière à peu près homogène par des personnes de différents genres, âges et idéologies politiques. Il est intéressant de constater que les membres du personnel militaire en service actif, qui ont une compréhension directe de la réalité des conflits armés, constituent le groupe qui a le plus fermement rejeté les armes entièrement autonomes, 73 pour cent d’entre eux s’étant déclarés opposés à celles-ci[102]. La majorité des personnes interrogées pour ce sondage ont également apporté leur soutien à une campagne en faveur de l’interdiction de ces armes[103]. Plus récemment, d’après une étude nationale conduite auprès d’un millier de Belges et publiée le 3 juillet 2018, 60 pour cent des personnes interrogées estimaient que la « Belgique devrait soutenir les efforts internationaux visant à interdire la mise au point, la production et l’utilisation d’armes entièrement autonomes ». Seuls 23 pour cent des personnes interrogées n’étaient pas d’accord[104].

Des sondages menés à l’échelle internationale ont eu des résultats similaires. En 2015, Open Robotics Initiative a interrogé plus d’un millier de personnes dans 54 pays différents, et 56 pour cent des personnes interrogées se sont dites opposées à la mise au point et à l’utilisation de systèmes d’armes létales autonomes[105]. Au total, 34 pour cent des personnes ayant répondu au sondage ont rejeté la mise au point et l’utilisation de ces armes, car « l’être humain devrait toujours être celui qui prend les décisions de vie ou de mort »[106]. Parmi les autres motifs de rejet moins cités se trouvaient le manque de fiabilité des armes, le risque de prolifération et l’absence de responsabilité[107]. Une étude encore plus vaste, conduite par Ipsos auprès de 11 500 personnes dans 25 pays a produit les mêmes résultats[108]. Cette étude expliquait que les Nations Unies étaient en train d’examiner les « retombées stratégiques, juridiques et morales des systèmes d’armes autonomes » (autre terme désignant les armes entièrement autonomes) et demandait aux participants leur avis sur l’utilisation de ces armes. Au total, 56 pour cent ont fait part de leur opposition[109].

Organisations non gouvernementales et internationales

En apportant davantage de preuves étayant les préoccupations au regard de la conscience publique, des experts issus de différents domaines se sont sentis contraints, en particulier pour des raisons morales, d’appeler à l’interdiction de la mise au point, de la production et de l’utilisation des armes entièrement autonomes. La coalition Campagne contre les robots tueurs, qui regroupe 75 ONG, est à la tête du mouvement pour l’interdiction des armes entièrement autonomes[110]. Les ONG qui la composent agissent dans une trentaine de pays et comptent des groupes spécialisés dans des domaines pertinents comme le désarmement humanitaire, la paix et la résolution de conflits, la technologie ou les droits humains[111]. Human Rights Watch, qui a cofondé cette coalition en 2012, assure sa coordination. Au cours des six dernières années, les organisations membres ont mis en avant les nombreux problèmes associés aux armes entièrement autonomes en réalisant des dizaines de publications et de déclarations lors de réunions diplomatiques et d’événements organisés par les Nations Unies, sur les réseaux sociaux et dans d’autres tribunes publiques[112].

Même s’il est vrai que différentes préoccupations trouvent un écho auprès de différentes personnes, Steve Goose, directeur de la division Armes de Human Rights Watch, a souligné l’importance de la clause de Martens dans sa déclaration lors de la réunion en avril 2018 du Groupe d’experts gouvernementaux de la Convention sur certaines armes classiques. Il a ainsi déclaré :

Si de nombreuses raisons justifient le rejet [des systèmes d’armes létales autonomes] (notamment des préoccupations relatives à l’aspect juridique, technique et opérationnel, à la prolifération et à la sécurité internationale), les préoccupations éthiques et morales, qui créent un sentiment de répulsion, les éclipsent toutes. Ces préoccupations éthiques devraient pousser les Hautes Parties contractantes à la Convention sur certaines armes classiques à tenir compte de la clause de Martens dans le droit international humanitaire, en vertu duquel les armes allant à l’encontre des principes de l’humanité et des exigences de la conscience publique ne devraient pas être mises au point[113].

Le CICR a invité les États à évaluer les armes entièrement autonomes au regard de la clause de Martens et a constaté que, « [e]n ce qui a trait aux exigences de la conscience publique, l’idée d’un système d’armes qui placerait l’utilisation de la force hors de tout contrôle humain suscite un profond sentiment de malaise »[114]. Le CICR a, à plusieurs reprises, souligné la nécessité juridique et éthique du contrôle humain des fonctions essentielles de sélection et d’attaque de cibles. En avril 2018, le CICR a clairement fait savoir qu’il estimait qu’un « niveau minimal de contrôle humain est nécessaire pour garantir le respect des règles du droit international humanitaire qui protège les civils et les combattants dans les conflits armés, et pour veiller à l’acceptabilité éthique relative aux principes de l’humanité et à la conscience publique »[115]. Le CICR a expliqué que le droit international humanitaire « exige que les personnes chargées de planifier, de valider et de mener à bien des attaques portent des jugements lorsqu’elles appliquent les principes au moment de lancer une attaque. Des considérations éthiques font écho à cette nécessité, exigeant que l’intervention et l’intention humaine subsistent dans les décisions d’avoir recours à la force »[116]. Le CICR a conclu qu’un système d’armes hors de tout contrôle humain « serait illégal de par sa nature même »[117]

Leaders de mouvements pacifiques et religieux

En 2014, plus d’une vingtaine de personnes et d’organisations lauréates du prix Nobel ont rédigé une lettre ouverte déclarant qu’elles « partagent sans réserve la volonté d’obtenir une interdiction préventive des armes entièrement autonomes » et qu’elles estiment qu’il est « inadmissible que l’être humain approfondisse la recherche et le développement de machines létales qui pourraient tuer sans intervention humaine »[118]. Parmi les signataires de la lettre se trouvent la militante américaine Jody Williams, qui a mené le mouvement de la société civile en faveur de l’interdiction des mines terrestres, des chefs d’État et des figures politiques, des militants des droits humains et pour la paix, un juriste, un journaliste et un chef religieux[119]. Pugwash Conferences on Science and World Affairs, organisation signataire, et Nobel Women’s Initiative, qui est elle aussi à l’origine de la lettre, sont toutes deux membres du comité directeur de la coalition Campagne contre les robots tueurs.

De la même manière, des chefs religieux se sont eux aussi unis contre les armes entièrement autonomes. En 2014, plus de 160 chefs religieux ont signé une « déclaration interconfessionnelle appelant les États à agir pour l’interdiction des armes entièrement autonomes à l’échelle internationale » [120]. Faisant part de préoccupations au regard des principes de l’humanité, la déclaration qualifie ces armes d’« affront à la dignité humaine et au caractère sacré de la vie » [121]. La déclaration rejette l’idée de confier à une machine la décision de vie ou de mort, car les armes entièrement autonomes n’ont « pas de représentation morale et, par conséquent, ne peuvent être tenues pour responsables si elles prennent une vie innocente » [122]. Parmi les signataires, on trouve des représentants du bouddhisme, du catholicisme, de l’islam, du judaïsme, du protestantisme et du quakerisme. L’archevêque Desmond Tutu a signé cette déclaration et la lettre rédigée par les lauréats du prix Nobel de la paix.

Experts des sciences et technologies

Des personnes possédant des compétences poussées en technologie ont elles aussi fait part de leur opposition aux armes entièrement autonomes. International Committee for Robot Arms Control (ICRAC), dont les membres s’intéressent aux développements technologiques dans différents domaines, a tiré la sonnette d’alarme en 2013, peu de temps après avoir cofondé la coalition Campagne contre les robots tueurs [123]. ICRAC a publié une déclaration qui a reçu le soutien de plus de 270 spécialistes et qui appelle à l’interdiction de la mise au point et du déploiement des armes entièrement autonomes [124]. Les membres d’ICRAC constatent « l’absence de preuve scientifique manifeste que les armes-robots possèdent, ou sont susceptibles de posséder dans un avenir prévisible, les fonctionnalités nécessaires pour procéder avec exactitude à l’identification d’une cible, à l’analyse de la situation ou à la prise de décision concernant l’usage proportionnel de la force » et concluent que « [l]es décisions relatives à l’usage violent de la force ne doivent pas être déléguées à des machines »[125]. Les préoccupations mises en avant dans cette déclaration sont axées sur la technologie ; néanmoins, comme évoqué plus haut, l’incapacité de prendre des décisions concernant la proportionnalité peut aller à l’encontre du respect de la vie et des principes de l’humanité.

En 2015, un ensemble encore plus important de chercheurs en intelligence artificielle et en robotique ont publié une lettre ouverte. Au mois de juin 2018, plus de 3 500 scientifiques et plus de 20 000 personnes avaient signé cet appel en faveur d’une interdiction [126]. La lettre alerte sur le fait que ces machines pourraient devenir les « Kalashnikovs de demain » si leur mise au point n’est pas interdite [127]. Elle explique par ailleurs que, bien que les signataires « soient convaincus que les potentielles retombées positives de l’intelligence artificielle pour l’humanité sont énormes », ils « estiment qu’une course à l’armement dans le domaine de l’intelligence artificielle ne serait pas bénéfique pour l’humanité. L’intelligence artificielle peut rendre le champ de bataille plus sûr pour les êtres humains, en particulier les civils, de nombreuses façons, sans pour autant créer de nouveaux outils pour tuer » [128].

Des milliers d’experts dans le domaine des technologies ont appelé chacun à agir, et se sont engagés à ne pas participer à l’avancement de la mise au point d’armes entièrement autonomes. Lors d’un sommet international organisé à Stockholm en 2018, des chercheurs en intelligence artificielle ont publié un engagement à « ne pas apporter leur participation ou leur soutien à la mise au point, la fabrication, la commercialisation ou l’utilisation des armes létales autonomes »[129]. Avant la fin du mois, plus de 2 850 spécialistes, scientifiques et acteurs du domaine de l’intelligence artificielle ainsi que 223 entreprises et organisations technologiques d’au moins 36 pays avaient signé l’appel. Cet engagement, qui exprime des préoccupations au regard de questions morales, de responsabilité, de prolifération et de sécurité, conclut que « la décision de prendre une vie humaine ne devrait jamais être confiée à une machine ». Le document précise : « Il y a un aspect moral à cette opinion : nous ne devrions pas permettre à des machines de prendre des décisions de vie ou de mort dont quelqu’un aura à répondre ou dont personne ne sera responsable[130] ». D’après Future of Life Institute, qui publie l’engagement sur son site Internet, ce document est nécessaire, car « les dirigeants politiques ont jusque-là échoué à faire entrer en vigueur » des textes réglementaires et juridiques opposés aux systèmes d’armes létales autonomes[131].

Représentants d’industries

Des entreprises technologiques de premier plan et leurs représentants ont formulé des critiques diverses envers les armes entièrement autonomes. Un fabricant canadien de robots, ClearPath Robotics, est devenu la première entreprise à refuser publiquement de produire des « robots armés fonctionnant sans intervention humaine » [132]. En 2014, l’entreprise s’est engagée à « privilégier l’éthique plutôt que les bénéfices potentiels » [133]. Dans une lettre publique, l’entreprise a expliqué être motivée par sa conviction que « la mise au point de robots tueurs est imprudente, contraire à l’éthique et devrait être interdite à l’échelle internationale ». ClearPath Robotics a également expliqué :

[U]n robot aurait-il le sens moral, le jugement ou la compréhension émotionnelle pour désobéir à des ordres injustes ou manquant d’humanité ? Non. Les ordinateurs seraient-ils en mesure de prendre les décisions subjectives nécessaires pour vérifier le caractère légitime des cibles et pour garantir que la force est utilisée de manière proportionnelle dans un avenir proche ? Non. Cette technologie pourrait-elle pousser ses détenteurs à rabaisser la valeur d’une vie humaine ? En toute franchise, nous pensons que ce serait le cas. [134]

Ce message montre que les armes entièrement autonomes posent problème au regard du principe de l’humanité et des exigences de la conscience publique.

En août 2017, les créateurs et les dirigeants de 116 entreprises dans les domaines de l’intelligence artificielle et de la robotique ont publié une lettre appelant les États parties à la Convention sur certaines armes classiques à prendre des mesures concernant les armes autonomes[135]. La lettre commence comme suit : « En tant qu’entreprises qui créons les technologies de l’intelligence artificielle et de la robotique qui pourraient être utilisées pour mettre au point des armes autonomes, nous pensons qu’il nous incombe de tirer la sonnette d’alarme » [136]. Le texte insiste ensuite sur les dangers pour les civils, le risque d’une course à l’armement et un possible effet déstabilisateur. Il formule la mise en garde suivante : « [u]ne fois cette boîte de Pandore ouverte, il sera très difficile de la refermer »[137]. De la même manière, en 2018, Scott Phoenix (à la tête de Vicarious, une entreprise de développement de l’intelligence artificielle de premier plan) a décrit la mise au point d’armes autonomes comme faisant partie des « pires idées du monde » en raison de la présence probable d’anomalies dans leur code et de leur vulnérabilité face au piratage[138].

À de multiples reprises, Google et les entreprises appartenant à son groupe Alphabet se sont retrouvées au centre des débats sur les armes entièrement autonomes. DeepMind est une entreprise de recherche sur l’intelligence artificielle rachetée par Google en 2014. En 2016, elle a présenté devant un comité parlementaire du Royaume-Uni des documents prouvant que l’interdiction des armes autonomes est « la meilleure approche pour éviter les conséquences préjudiciables entraînées par la mise au point et l’utilisation de celles-ci » [139]. Les préoccupations exprimées par DeepMind portaient en particulier sur les « répercussions, à l’échelle internationale, sur la stabilité et la réduction du nombre de conflits » [140]. Deux ans plus tard, plus de 3 000 employés de Google ont contesté la participation de l’entreprise au programme « Project Maven » du département de la Défense des États-Unis ayant pour but d’utiliser l’intelligence artificielle pour traiter les documents vidéo tournés par les drones de surveillance. Pour les employés, l’entreprise ne devrait pas « participer à l’économie de la guerre » [141]. Plus de 1 100 universitaires leur ont apporté leur soutien dans une lettre distincte[142]. En juin 2018, Google a accepté de se retirer du programme Project Maven à la fin du contrat correspondant, en 2019, et a publié des principes éthiques dans lesquels l’entreprise s’engage à ne pas développer l’intelligence artificielle destinée à être utilisée par des armes. Dans ses principes, Google s’engage à « ne pas développer une intelligence artificielle destinée à être utilisée dans des armes » et à « ne pas concevoir ou employer l’intelligence artificielle » dans le cadre de technologies à l’origine de « préjudices globaux » ou allant « à l’encontre des principes couramment admis du droit international et des droits humains » [143].

Les investisseurs de l’industrie des technologies commencent eux aussi à réagir face aux préoccupations éthiques soulevées par les armes entièrement autonomes. En 2016, le comité éthique de la caisse de pensions du gouvernement norvégien a annoncé qu’il allait contrôler les investissements réalisés dans la mise au point de ces armes afin de déterminer s’ils vont à l’encontre des lignes directrices du comité[144]. Johan H. Andresen, président du comité, a réitéré cet engagement lors d’un exposé devant les délégués de la Convention sur certaines armes classiques en avril 2018[145].

Avis de gouvernements

De plus en plus, des gouvernements du monde entier partagent le point de vue des experts et du grand public selon lequel il est inacceptable d’élaborer, de produire et d’utiliser des armes ne nécessitant pas de contrôle humain significatif. En avril 2018, 26 nations d’Afrique, d’Asie, d’Europe, d’Amérique latine et du Moyen-Orient ont demandé l’interdiction préventive des armes entièrement autonomes[146]. En outre, plus de 100 États, y compris des pays appartenant au Mouvement des non-alignés, ont demandé l’élaboration d’un instrument juridiquement contraignant relatif à ces armes. Dans une intervention conjointe, les membres du Mouvement des non-alignés ont cité des questions éthiques, juridiques, morales et techniques, ainsi que des questions de paix et de sécurité internationale, comme sujets de préoccupation[147]. Même si une analyse complète des interventions faites par des gouvernements à ce propos au cours des cinq dernières années dépasserait le cadre de ce rapport, les déclarations montrent dans l’ensemble que les pays sont opposés à la perte de contrôle humain, entre autres pour des raisons morales, juridiques et techniques. Les avis de ces gouvernements, qui reflètent les préoccupations du public, viennent renforcer l’argument selon lequel les armes entièrement autonomes vont à l’encontre des exigences de la conscience publique.

Les principes cités dans la clause de Martens ont influencé les discussions internationales sur les armes entièrement autonomes depuis qu’elles ont commencé, en 2013. Cette année-là, Christof Heyns, alors rapporteur spécial sur les exécutions extrajudiciaires, sommaires ou arbitraires, a rendu au Conseil des droits de l’homme des Nations Unies un rapport sur les armes entièrement autonomes, qu’il qualifie de « robots létaux autonomes »[148]. Soulignant l’importance de conserver un contrôle humain sur les décisions de vie et de mort, Heyns explique que « [l]a plupart des codes juridiques, moraux et autres reposent sur le postulat que, lorsqu’il s’agit d’ôter la vie de personnes ou de les soumettre à d’autres conséquences graves, le pouvoir de décision doit être exercé par l’être humain » [149]. Il poursuit : « Le fait de déléguer ce processus déshumanise encore plus les conflits armés et empêche toute possibilité de délibération, même lorsque cela est possible. Les machines n’ont pas de morale et ne sont pas mortelles, et à ce titre ne devraient pas avoir un pouvoir de vie et de mort sur les êtres humains »[150]. Heyns cite aussi la clause de Martens comme l’un des fondements juridiques de son argumentation[151]. Le rapport de 2013 appelait à l’instauration d’un moratoire sur le développement des armes entièrement autonomes « en attendant la mise en place d’un cadre convenu à l’échelle internationale »[152]. Dans un rapport conjoint publié en 2016, Heyns et Maina Kiai, Rapporteur spécial des Nations Unies sur le droit de réunion pacifique et d'association de l’époque, sont allés plus loin en recommandant : « [l]es systèmes d’armes autonomes qui ne requièrent aucun contrôle humain effectif devraient être interdits »[153].

En mai 2013, à la suite du rapport de Heyns, le Conseil des droits de l’homme des Nations Unies a organisé les premières discussions relatives aux armes au niveau international[154]. Sur les 20 nations ayant exprimé leur position, un grand nombre ont formulé des préoccupations concernant les technologies émergentes. Souvent, les propos employés étaient liés à la clause de Martens ou, plus généralement, à la question de la moralité. L’Équateur a fait explicitement référence au contenu de la clause de Martens et a déclaré que le fait de laisser des machines prendre des décisions de vie et de mort irait à l’encontre des exigences de la conscience publique[155]. L’Indonésie a soulevé des objections liées aux principes de l’humanité évoqués plus haut. Elle a critiqué les « possibles répercussions profondes sur les valeurs sociétales, y compris essentiellement sur la protection et la valeur de la vie » que pourrait avoir l’usage de ces armes[156]. La Russie a recommandé qu’une « attention particulière » soit portée aux « graves conséquences sur les fondements de la société, notamment la négation de la vie humaine » [157]. Le Pakistan a demandé une interdiction fondée sur le précédent de l’interdiction préventive des lasers aveuglants, motivée en grande partie par la clause de Martens[158]. Le Brésil a également invoqué la question de la moralité : « Si le fait qu’un être humain en tue un autre est un problème avec lequel les codes juridiques, moraux et religieux tentent de composer depuis toujours, on peut imaginer le nombre de préoccupations que soulèverait l’existence de robots exerçant un droit de vie ou de mort sur des humains »[159]. Même si les États membres du Conseil des droits de l’homme ont également évoqué d’autres risques importants liés aux armes entièrement autonomes, en particulier ceux relatifs à la sécurité, la morale reste une préoccupation majeure[160].