Resumen

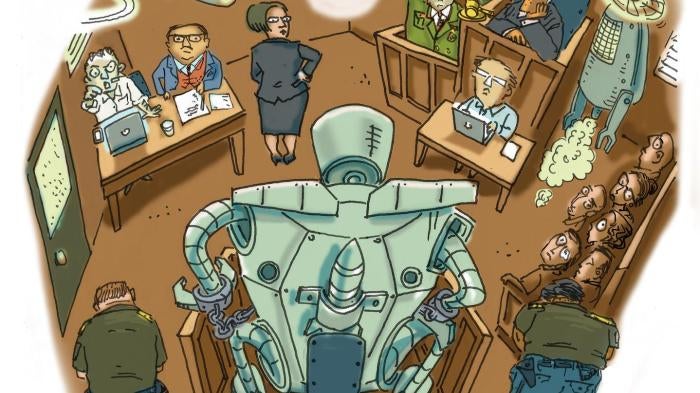

Las armas completamente autónomas, también conocidas como “robots asesinos”, plantean serias preocupaciones morales y legales dado que poseerían la capacidad de seleccionar y atacar a sus objetivos sin un control humano significativo. Muchas personas se preguntan si la decisión de matar a un ser humano debería dejarse en manos de una máquina. De la misma forma, hay serias dudas de que las armas completamente autónomas puedan replicar el juicio humano y cumplir con el requisito legal de distinguir entre objetivos civiles y militares. Otras amenazas potenciales incluyen la perspectiva de una carrera de armamentos y la proliferación de las fuerzas armadas con poco respeto por la ley.

Estas preocupaciones se ven agravadas por los obstáculos a la rendición de cuentas que existirían por daños ilegales causados por armas completamente autónomas. Este informe analiza en profundidad los obstáculos para responsabilizar a las personas por las acciones de este tipo de armas. También muestra que incluso si un caso tuvo éxito en la asignación de responsabilidad, la naturaleza de la responsabilidad resultante podría no cumplir con los objetivos de disuadir daños futuros y proporcionar justicia retributiva a las víctimas.

Las armas completamente autónomas no pueden sustituir a los humanos responsables como acusados en ningún procedimiento legal que busque lograr la disuasión y el castigo. Además, una variedad de obstáculos legales hace probable que los humanos asociados con el uso o la producción de estas armas, especialmente los operadores y comandantes, programadores y fabricantes, escapen a la responsabilidad del sufrimiento causado por las armas completamente autónomas. Ni el derecho penal ni el derecho civil garantizan una responsabilidad adecuada de las personas que participan directa o indirectamente en el uso de armas completamente autónomas.

La necesidad de responsabilidad personal deriva de los objetivos del derecho penal y los deberes específicos que imponen el derecho internacional humanitario y los derechos humanos. Con respecto a los objetivos, el castigo de actos ilegales pasados tiene como objetivo disuadir la comisión de actos futuros por parte de perpetradores y observadores conscientes de las consecuencias. Además, responsabilizar a un autor cumple una función retributiva. Da a las víctimas la satisfacción de que un culpable fue condenado y castigado por el daño que sufrieron, ayuda a evitar la culpa colectiva y promueve la reconciliación. En cuanto a los deberes, el derecho internacional humanitario exige la responsabilidad personal por violaciones graves, también conocidas como crímenes de guerra. El derecho internacional de los derechos humanos, además, establece el derecho a un recurso, que abarca varias formas de reparación; por ejemplo, obliga a los Estados a investigar y procesar violaciones graves de las leyes de derechos humanos y hacer cumplir los juicios en las demandas civiles de las víctimas contra actores privados.

Los mecanismos existentes para la responsabilidad legal son inadecuados para hacer frente a los daños ilegales que pueden causar las armas completamente autónomas. Estas armas tienen el potencial de cometer actos delictivos, actos ilegales que constituirían un delito si se hicieran con intención, por lo que nadie podría ser considerado responsable. Un arma completamente autónoma en sí misma no podría ser considerada responsable por actos criminales porque carecería de intencionalidad.[1] Además, dicho robot no caería dentro de la jurisdicción de “persona física” de los tribunales internacionales. Incluso si dicha jurisdicción fuera enmendada para abarcar una máquina, un juicio no cumpliría los propósitos de castigo para la sociedad o la víctima, porque el robot no podría ser disuadido por la condena ni percibir o apreciar que se lo “castigara”.

A los comandantes u operadores humanos no se les podría asignar responsabilidad directa por las acciones ilícitas de un arma totalmente autónoma, excepto en circunstancias excepcionales en las que se pudiera demostrar que esas personas poseían la intención específica y la capacidad de cometer actos criminales mediante el uso indebido de armas completamente autónomas. En la mayoría de los casos, tampoco sería razonable imponer un castigo penal al programador o fabricante, que podría no tener la intención específica, ni prever, la comisión de actos ilícitos por parte del robot.[2]

La naturaleza autónoma de los robots asesinos los haría, de alguna manera, legalmente análogos a los soldados humanos y así podría desencadenar la doctrina de la responsabilidad indirecta o la responsabilidad de mando. Sin embargo, un comandante todavía escaparía a la responsabilidad en la mayoría de los casos. La responsabilidad del comando solo sería de los superiores si supieran o debían haber sabido que se iba a efectuar un acto delictivo por parte de un subordinado y no lo impidieron o castigaron. Estos criterios establecen un alto nivel de responsabilidad para las acciones de un arma totalmente autónoma.

La responsabilidad del comando se ocupa de la prevención de un crimen, y como los robots no pueden tener el estado mental para cometer un crimen subyacente, la responsabilidad del comando nunca estará disponible en situaciones relacionadas con estas armas. Sin embargo, si se dejara a un lado ese problema, dado que las armas están diseñadas para operar de manera independiente, un comandante no siempre tendría suficiente razón o conocimiento tecnológico para anticipar que el robot cometería un acto ilícito específico. Incluso si supiera acerca de un posible acto ilegal, el comandante a menudo sería incapaz de impedirlo, por ejemplo, si las comunicaciones se interrumpieran y el robot actuara demasiado rápido para ser detenido o la reprogramación fuera demasiado difícil para cualquier persona excepto para los especialistas. Además, “castigar” al robot después del hecho no tendría sentido. Al final, las armas completamente autónomas no encajarían bien en el esquema de responsabilidad penal diseñado para los humanos, y su uso crearía el riesgo de actos ilegales y daños civiles importantes, por los cuales, nadie podría ser considerado criminalmente responsable.

Un enfoque alternativo sería responsabilizar a un comandante o programador por negligencia si, por ejemplo, los actos ilegales provocados por robots fueran razonablemente previsibles, incluso si no se pretendían. Dicha responsabilidad civil puede ser una herramienta útil para proporcionar compensación a las víctimas y proporciona un grado de disuasión y cierto sentido de justicia para los perjudicados. Sin embargo, impone penas menores que el derecho penal y, por lo tanto, no alcanza el mismo nivel de condena social asociado con el castigo de un delito.

Independientemente de la naturaleza de las sanciones, los intentos de utilizar mecanismos de responsabilidad civil para establecer la responsabilidad por los daños causados por armas completamente autónomas, serían igualmente poco probables de tener éxito. A nivel práctico, incluso en un sistema legal funcional, a la mayoría de las víctimas les resultaría difícil demandar a un usuario o fabricante, porque sus demandas probablemente serían costosas, consumirían mucho tiempo y dependerían de la asistencia de expertos que pudieran abordar los complejos problemas legales y técnicos derivados del uso de armas completamente autónomas. Las barreras legales para la responsabilidad civil son incluso mayores que las barreras prácticas. Se ejemplifican por las limitaciones del sistema de responsabilidad civil de Estados Unidos, un país que generalmente es amigable con los litigios y un líder en el desarrollo de tecnología autónoma.

La inmunidad para el ejército estadounidense y sus contratistas de defensa, presenta un obstáculo casi insuperable para la responsabilidad civil de los usuarios o productores de armas completamente autónomas. El ejército es inmune a los juicios relacionados con: (1) sus determinaciones de políticas, que probablemente incluyan una selección de armas, (2) las actividades de combate de las fuerzas militares, y (3) los actos cometidos en un país extranjero. Los fabricantes contratados por el ejército son igualmente inmunes cuando diseñan un arma de acuerdo con las especificaciones del gobierno y sin engañar deliberadamente al ejército. Estos mismos fabricantes también son inmunes a las reclamaciones civiles relacionadas con actos cometidos durante la guerra.

Incluso sin estas reglas de inmunidad, a un demandante le resultaría difícil establecer que un arma totalmente autónoma estaba legalmente defectuosa para los fines de una demanda por responsabilidad civil por productos defectuosos. La complejidad del software de un robot autónomo dificultaría demostrar que tenía un defecto de fábrica, es decir, un defecto de producción que le impedía operar como se había diseñado. El hecho de que un arma completamente autónoma matara a civiles no necesariamente indicaría un defecto de fabricación: un robot podría haber actuado dentro de los límites del derecho internacional humanitario, o las muertes podrían haber sido atribuidas a un programador que no previó ni planificó la situación. La capacidad de los demandantes para demostrar que el diseño de las armas era defectuoso se vería obstaculizada, de alguna manera, por la complejidad de la tecnología, la falta de disponibilidad de armas alternativas existentes para servir como puntos de comparación y la limitada utilidad de las advertencias donde los peligros inherentes a un arma que opera de manera independiente suele ser aparente pero impredecible en detalles.

Se ha propuesto un sistema de compensación sin establecer fallas para otras tecnologías autónomas. Bajo tal esquema, las víctimas tendrían que proporcionar solo una prueba de que han sido dañadas, no una prueba de que el producto era defectuoso. Sin embargo, este enfoque no llenaría el vacío de responsabilidad que existiría si se usaran armas completamente autónomas. La compensación sin culpa no es lo mismo que la rendición de cuentas, y las víctimas de armas completamente autónomas tienen derecho a un sistema que castigue a los responsables de daños graves, disuada más daños y demuestre que se ha hecho justicia.

Algunos defensores de las armas completamente autónomas argumentan que el uso de las armas sería aceptable en circunstancias limitadas, pero una vez que se desarrollen y se desplieguen, sería difícil restringirlas a tales situaciones. Los defensores también señalan que un programador u operador podría ser responsabilizado en ciertos casos como cuando se prueba la intención criminal. Sin embargo, como se explica en este informe, hay muchos otros casos previsibles que involucran armas completamente autónomas donde la responsabilidad penal y civil no tendría éxito. Incluso si la ley adoptara un estricto régimen de responsabilidad que permitiera compensar a las víctimas, no serviría a los propósitos de disuasión y retribución que el derecho internacional humanitario y los derechos humanos buscan lograr. Este informe sostiene que los Estados deben eliminar este vacío de responsabilidad adoptando una prohibición internacional de armas completamente autónomas.

Recomendaciones

Para anticiparse al vacío de responsabilidad que surgiría si se fabricaran y desplegaran armas completamente autónomas, Human Rights Watch y la Clínica Internacional de Derechos Humanos de la Escuela de Derecho de Harvard (IHRC) recomiendan a los Estados:

· Prohibir el desarrollo, la producción y el uso de armas completamente autónomas a través de un instrumento internacional legalmente vinculante.

· Adoptar leyes y políticas nacionales que prohíban el desarrollo, la producción y el uso de armas completamente autónomas.

I. Armas completamente autónomas y sus riesgos

Las armas completamente autónomas son sistemas de armas que seleccionan y atacan objetivos sin un control humano significativo. También son conocidas como robots asesinos o sistemas de armas autónomas letales. Debido a su plena autonomía, no habría humanos involucrados o human in the loop para dirigir su uso de la fuerza y, por lo tanto, representarían un paso más allá de los actuales drones controlados a distancia.[3]

Las armas completamente autónomas aún no existen, pero la tecnología se está moviendo en esa dirección y hay modelos precursores que ya están en uso o en desarrollo. Por ejemplo, muchos países utilizan sistemas de defensa con armas, como la Cúpula de Hierro israelí y el Phalanx y C-RAM de EE.UU., que están programados para responder automáticamente a las amenazas de las municiones entrantes. Además, existen prototipos para aviones que podrían volar de forma autónoma en misiones intercontinentales (UK Taranis) o despegar y aterrizar en un portaaviones (US X-47B).[4]

La falta de un control humano significativo coloca a las armas completamente autónomas en una posición ambigua y preocupante. Por un lado, mientras que las armas tradicionales son herramientas en manos de los seres humanos, las armas completamente autónomas, una vez desplegadas, harían sus propias determinaciones sobre el uso de la fuerza letal. Por lo tanto, desafiarían las nociones de larga data sobre el papel de las armas en los conflictos armados y, para algunos análisis legales, serían más parecidos a un soldado humano que a un arma inanimada. Por otro lado, las armas completamente autónomas no llegarían a ser como un humano. De hecho, se parecerían a otras máquinas por su falta de ciertas características humanas, como el juicio, la compasión y la intencionalidad. Esta cualidad subyace a muchas de las objeciones que se han planteado en respuesta a la perspectiva de armas completamente autónomas. Este informe analiza una de las objeciones más importantes: la dificultad de asegurar la responsabilidad cuando las armas completamente autónomas se involucran en la comisión de actos ilegales.

Riesgos planteados por armas completamente autónomas

Mientras que los defensores de armas completamente autónomas promocionan ventajas militares tales como tiempos de reacción más rápidos que los humanos y una mayor protección de las fuerzas amigas, los opositores, incluidos Human Rights Watch y el IHRC, creen que los riesgos acumulados superan cualquier beneficio.[5] Desde una perspectiva moral, muchas personas consideran objetable la idea de delegar en las máquinas el poder de hacer determinaciones de vida o muerte en conflictos armados o en situaciones de aplicación de la ley. Además, aunque las armas completamente autónomas no se verían afectadas por el miedo o la ira, carecerían de compasión, un aspecto clave contra el asesinato de civiles. Debido a que estas armas revolucionarían la guerra, también podrían desencadenar una carrera de armamentos; si un Estado obtuviera tales armas, otros Estados también podrían sentirse obligados a adquirirlas. Una vez desarrolladas, las armas completamente autónomas probablemente proliferarían en Estados irresponsables o grupos armados no estatales, dándoles máquinas que podrían programarse para matar indiscriminadamente a sus propios civiles o poblaciones enemigas. Algunos críticos también argumentan que el uso de robots podría facilitar que los líderes políticos recurrieran a la fuerza, porque usar tales robots reduciría el riesgo para sus propios soldados. Esta dinámica probablemente cambiaría la carga del conflicto armado de combatientes a civiles.

Finalmente, las armas completamente autónomas se enfrentarían a desafíos importantes para cumplir con el derecho internacional, porque carecerían de las características humanas generalmente requeridas para adherirse, durante los conflictos armados, a las reglas fundamentales del derecho internacional humanitario como las reglas de distinción y proporcionalidad.[6] Al usarse en situaciones de conflicto no armado como una forma de aplicación de la ley, las armas completamente autónomas podrían socavar el derecho humano a la vida y el principio de la dignidad humana. Los obstáculos para el cumplimiento, que se detallan a continuación, no solo ponen en peligro a los civiles, sino que también aumentan la necesidad de un sistema efectivo de responsabilidad legal para responder a cualquier violación que pueda ocurrir.

Derecho internacional humanitario: distinción y proporcionalidad

Las armas completamente autónomas enfrentarían grandes dificultades, si no insuperables, para distinguir de manera confiable entre objetivos legales e ilegales, tal como lo exige el derecho internacional humanitario. Las armas carecerían de cualidades humanas que faciliten la toma de tales determinaciones, particularmente en campos de batalla contemporáneos, donde los combatientes a menudo buscan ocultar sus identidades. Distinguir a un combatiente activo de un civil o de una persona herida o de un soldado en el proceso de rendirse, requiere más que las capacidades sensoriales y de procesamiento profundas que podrían desarrollarse. También depende de la capacidad cualitativa para medir la intención humana, que implica la interpretación de pistas sutiles, que dependen del contexto, del tono de voz, las expresiones faciales o el lenguaje corporal. Los seres humanos poseen la capacidad única de identificarse con otros seres humanos y, por lo tanto, están equipados para comprender los matices de los comportamientos imprevistos en formas en que las máquinas, que deben programarse de antemano, simplemente no lo son.

Los obstáculos presentados por el principio de distinción se combinan cuando se trata de proporcionalidad, que prohíbe los ataques en los que el daño civil esperado supera la ventaja militar prevista. Debido a que la proporcionalidad se basa en gran medida en una multitud de factores contextuales, la respuesta legal a una situación podría cambiar considerablemente al alterar ligeramente los hechos. Según la Fuerza Aérea de EE.UU., “la proporcionalidad en el ataque es una determinación inherentemente subjetiva que se resolverá caso por caso”.[7] Sería casi imposible pre programar una máquina para manejar el número infinito de escenarios que podría encarar. Además, el derecho internacional humanitario depende del juicio humano para tomar decisiones subjetivas, y la proporcionalidad es en última instancia “una cuestión de sentido común y buena fe para los comandantes militares”.[8] Sería difícil reproducir en las máquinas el juicio de un “comandante militar razonable”, que cuenta con la habilidad para evaluar la proporcionalidad en circunstancias imprevistas o cambiantes.[9] El incumplimiento del principio de proporcionalidad, además de la falta de distinción entre civiles y combatientes, podría llevar a una pérdida ilegal de vidas.

Derecho internacional de los derechos humanos: derecho a la vida y dignidad humana

Las armas completamente autónomas tienen el potencial de contravenir el derecho a la vida, que es la base del derecho internacional de los derechos humanos. Según el Pacto Internacional de Derechos Civiles y Políticos (PIDCP), “nadie será privado arbitrariamente de su vida”.[10] El uso de la fuerza letal solo es legal si cumple tres requisitos acumulativos sobre cuándo y cuánta fuerza puede utilizarse: debe ser necesario para proteger la vida humana, constituir un último recurso y aplicarse de manera proporcional a la amenaza. Cada uno de estos requisitos previos para el uso legal de la fuerza, implica evaluaciones cualitativas de situaciones específicas. Debido al número infinito de escenarios posibles, los robots podrían no ser programados previamente para manejar cada circunstancia específica. Además, cuando se enfrentan a situaciones imprevistas, las armas completamente autónomas serían propensas a realizar asesinatos arbitrarios porque enfrentarían desafíos para cumplir con los tres requisitos para el uso de la fuerza. Según muchos especialistas en robots, es muy poco probable que en un futuro previsible se puedan desarrollar robots que tengan ciertas cualidades humanas, como el juicio y la capacidad de identificarse con los humanos, que faciliten el cumplimiento de los tres criterios.[11]

El concepto de dignidad humana también se encuentra en el corazón del derecho internacional de los derechos humanos. Las palabras de apertura de la Declaración Universal de los Derechos Humanos (UDHR) afirman: “El reconocimiento de la dignidad inherente y de los derechos iguales e inalienables de todos los miembros de la familia humana, es la base de la libertad, la justicia y la paz en el mundo”.[12] Al atribuir una dignidad inherente a todos los seres humanos, la UDHR, basándose en Kant, implica que todos valen la pena y merecen respeto.[13] Las armas completamente autónomas tendrían el poder de matar a personas, porque al no ser humanas, no podrían respetar la dignidad de sus víctimas. Como máquinas inanimadas, no podrían comprender ni el valor de la vida humana individual ni el significado de su pérdida. Por lo tanto, además de poner en riesgo a los civiles, permitir que las armas completamente autónomas tomen decisiones para quitar la vida podría entrar en conflicto con el principio de dignidad.[14]

Las deficiencias de la regulación

Algunos defensores de las armas completamente autónomas argumentan que la respuesta a las preocupaciones legales discutidas anteriormente es limitar las circunstancias en las que se usan. Sostienen que existen algunos usos potenciales, no importa cuán limitados o improbables sean, donde las armas completamente autónomas podrían ser tanto militarmente valiosas como capaces de cumplir con los requisitos del derecho internacional humanitario. Un proponente, por ejemplo, señala que “no todos los espacios de batalla incluyen civiles”.[15] Otros proponentes sostienen que las armas completamente autónomas se pueden usar legalmente en “circunstancias limitadas”, como en ataques a “lanzamisiles móviles con ojivas nucleares, donde millones de vidas están en juego”.[16] Estos autores generalmente prefieren restringir el uso de armas completamente autónomas a tipos específicos de ubicaciones o propósitos.[17] Las regulaciones pueden venir en forma de un instrumento legalmente vinculante o un conjunto de estándares informales desarrollados gradualmente.[18]

El enfoque regulatorio no elimina todos los riesgos de las armas completamente autónomas dado que es difícil restringir el uso de armas a escenarios limitados. Una vez que las armas completamente autónomas surgieran bajo un régimen regulatorio, serían vulnerables al mal uso. Incluso si las regulaciones restringieran el uso de armas completamente autónomas a ciertos lugares o propósitos específicos, después de que las armas ingresaran a los arsenales nacionales, los países que usualmente respetan el derecho internacional humanitario, podrían verse tentados en el fragor de la batalla o en circunstancias extremas, a usar las armas de manera que aumentara el riesgo de violaciones de las leyes de guerra. Por ejemplo, antes de la adopción de la Convención de 2008 sobre Municiones en Racimo, los defensores de las municiones en racimo a menudo sostenían que las armas podían lanzarse legalmente solo contra un objetivo militar en un desierto despoblado. Sin embargo, incluso los militares generalmente responsables, hicieron un uso generalizado de las municiones en racimo en áreas pobladas. Tales posibilidades teóricas no deben utilizarse para legitimar armas, incluidas las totalmente autónomas, que presentan riesgos humanitarios significativos cuando se usan en situaciones menos excepcionales.

La existencia de armas completamente autónomas también posibilitaría su adquisición por parte de regímenes represivos o grupos armados no estatales que podrían ignorar las restricciones o alterar o anular cualquier programación diseñada para regular el comportamiento de un robot. Podrían usar las armas en ataques intencionales o indiscriminados contra su propia gente o contra civiles en otros países con horribles consecuencias.

Una prohibición absoluta y legalmente vinculante de armas completamente autónomas proporcionaría varias ventajas sobre las limitaciones formales o informales. Maximizaría la protección para los civiles en conflicto porque sería más integral que la regulación. Sería más efectiva, ya que prohibiría la existencia de las armas y sería más fácil de aplicar.[19] Una prohibición podría tener un poderoso efecto estigmatizador, creando una nueva norma ampliamente reconocida e influyendo incluso en aquellos que no se unieran a un tratado. Finalmente, evitaría otros problemas con un arma totalmente autónoma, como las objeciones morales y el potencial de una carrera de armamentos.

Una prohibición también minimizaría los problemas de responsabilidad que vienen con la regulación. Al legalizar el uso limitado de armas completamente autónomas, la regulación abriría la puerta a situaciones donde surgen desafíos de responsabilidad. Si las armas se desarrollaran y desplegaran, sería necesario responsabilizar a las personas por violaciones del derecho internacional que involucren el uso de ellas. Incluso si la responsabilidad fuera asignada a través de un esquema de responsabilidad estricta, simplemente produciría una compensación y no reflejaría el juicio moral ni lograría los objetivos de disuasión y retribución de la rendición de cuentas. El resto de este informe explica los obstáculos para garantizar la responsabilidad por los actos ilegales cometidos por armas completamente autónomas que cumplan estos objetivos.

II. La importancia de la responsabilidad personal

Cuando se producen violaciones del derecho internacional, no debe permitirse a los perpetradores escapar de la responsabilidad. Como señaló el erudito en derecho internacional M. Cherif Bassiouni, “la impunidad por los delitos internacionales y por las violaciones sistemáticas y generalizadas de los derechos humanos fundamentales es una traición a nuestra solidaridad humana con las víctimas de los conflictos a quienes debemos el deber de justicia, del recuerdo y de la compensación”.[20] En el mismo sentido, los Principios y directrices básicos sobre el derecho a un remedio y una reparación, adoptados por las Naciones Unidas en 2005, reconocen la importancia de “los principios jurídicos internacionales de responsabilidad, justicia y estado de derecho” y de establecer los elementos de un régimen de rendición de cuentas.[21] La rendición de cuentas puede venir en forma de responsabilidad estatal, lo que puede llevar a cambios en la conducta de un país.[22] Este informe, sin embargo, se centra en la responsabilidad personal, ya sea para las personas físicas o jurídicas, que castiga la conducta de un delincuente específico en lugar de un Estado.

El propósito de asignar responsabilidad personal según el derecho penal es disuadir futuras violaciones y proporcionar retribución a las víctimas. Dicha responsabilidad es exigida por el derecho internacional: el derecho internacional humanitario impone el deber de procesar los crímenes de guerra, y el derecho internacional de los derechos humanos establece el derecho a un recurso por infracción de otros derechos. La ley de derechos humanos también promueve la responsabilidad civil, que en la práctica puede cumplir algunos de los objetivos de la responsabilidad penal, pero tiene menos peso moral. Si bien la responsabilidad del Estado por los actos ilegales de armas completamente autónomas podría asignarse de manera relativamente fácil al Estado del usuario, como se analiza en los capítulos 3 y 4, sería difícil atribuir la responsabilidad personal por esos actos. Comprender los objetivos subyacentes y las obligaciones legales asociadas con la rendición de cuentas es un requisito previo para comprender la importancia del vacío potencial en la responsabilidad de los seres humanos o las corporaciones.

Propósitos de la responsabilidad penal

Una de las razones principales para responsabilizar a los individuos es disuadir el comportamiento dañino. Si los individuos son castigados por actos ilegales, es menos probable que los repitan. Hacer responsables a los delincuentes también puede desalentar futuras infracciones por parte de otros actores, que temen ser castigados de la misma manera. Según Dinah Shelton, autora del tratado Remedies in International Human Rights Law, “la disuasión se supone que funciona porque los actores racionales sopesan los costos anticipados de las transgresiones frente a los beneficios anticipados”.[23] Agrega que “la literatura también muestra una correlación entre la certeza de las consecuencias y la reducción de los delitos”.[24] Para que la disuasión tenga el máximo efecto, los delincuentes potenciales deben tener un aviso previo de la posibilidad de rendición de cuentas para que puedan considerar las consecuencias antes de actuar. Las garantías públicas de que se están tomando medidas para disminuir la probabilidad de nuevos delitos también pueden brindar consuelo a las víctimas y a la sociedad.

La rendición de cuentas sirve una función retributiva adicional.[25] La comisión de un acto ilegal contra otra persona “transmite un mensaje de que los derechos de la víctima no son lo suficientemente importantes como para abstenerse de violarlos en la búsqueda de otro objetivo”, mientras que el castigo le muestra “a los delincuentes y otras personas que hicieron daño a la víctima y, por lo tanto, reconoce implícitamente la difícil situación de la víctima y honra las demandas morales de la víctima”.[26] Responsabilizar a un individuo le da a las víctimas la satisfacción de saber que alguien está siendo condenado y castigado por el daño que sufrió, y envía el mensaje de que las vidas y los derechos de las víctimas tienen valor. Al especificar quién es el responsable más cercano, la responsabilidad personal también evita la culpa colectiva, lo que puede estimular la venganza o impedir la reconciliación, y desempeña un papel vital en la resolución posterior al conflicto, tanto para las víctimas como para la comunidad en general.[27]

Aunque no es estrictamente un objetivo de responsabilidad, un tercer propósito del derecho penal es la justicia compensatoria. Proporcionar una compensación a las víctimas a través de un proceso legal tiene como objetivo rectificar el daño experimentado y, por lo tanto, restaurar a la víctima a la condición en que se encontraba antes de que se infligiera el daño.[28] Tal compensación busca restaurar no solo un equilibrio económico entre las partes, sino también un equilibrio moral.[29] Además, promueve la autonomía de las víctimas al proporcionarles fondos que pueden ayudarles a alcanzar sus objetivos de vida individuales que se vieron obstaculizados por la lesión inicial. Si bien la compensación tiene varias funciones valiosas, no es un sustituto de la disuasión y la retribución.

Obligaciones legales internacionales

El derecho internacional humanitario y el derecho internacional de los derechos humanos requieren la rendición de cuentas por violaciones legales. El derecho internacional humanitario establece el deber de procesar los actos criminales cometidos durante los conflictos armados. El cuarto Convenio de Ginebra y su protocolo adicional I, y los instrumentos legales clave sobre protección de civiles, obligan a los Estados a procesar “violaciones graves”, es decir, crímenes de guerra, como atacar a civiles o lanzar un ataque con el conocimiento de que sería desproporcionado.[30] La obligación vincula el derecho internacional humanitario con el derecho penal internacional; el primero “proporciona la fuente de muchos de los crímenes procesados bajo el derecho penal internacional”.[31] Como resultado, muchos tribunales penales internacionales, incluida la Corte Penal Internacional (ICC, por sus siglas en inglés), el Tribunal Penal Internacional para la ex Yugoslavia (ICTY, por sus siglas en inglés), y el Tribunal Penal Internacional para Ruanda (ICTR, por sus siglas en inglés), tienen jurisdicción sobre los crímenes de guerra, el genocidio y los crímenes de lesa humanidad.[32] Si bien los juicios también pueden llevarse a cabo a nivel nacional, la responsabilidad personal exigida por el derecho internacional humanitario a menudo se implementa a través del derecho penal internacional.

El derecho internacional de los derechos humanos establece el derecho a remediar los abusos de todos los derechos humanos. El artículo 2 (3) del Pacto Internacional de Derechos Civiles y Políticos (PIDCP) exige a los Estados parte que “garanticen que cualquier persona cuyos derechos o libertades [...] sean violados tendrá un remedio efectivo”.[33] Destacando el valor de este derecho de disuasión, el Comité de Derechos Humanos ha declarado que, “los propósitos del Pacto serían derrotados sin la obligación [...] de tomar medidas para evitar que se vuelva a cometer una violación”.[34] Según el derecho a un recurso, el derecho internacional de los derechos humanos, como el derecho internacional humanitario, exige el enjuiciamiento de individuos por violaciones graves de la ley, en particular genocidio y crímenes de lesa humanidad. Según el Comité de Derechos Humanos, el PIDCP obliga a los Estados parte a investigar las denuncias de irregularidades y, si encuentran evidencia de ciertos tipos de violaciones, a llevar a los responsables ante la justicia.[35] El hecho de no investigar y, cuando corresponda, procesar “podría en sí mismo dar lugar a una violación separada del Pacto”.[36]

Los Principios y directrices básicos sobre el derecho a un remedio y una reparación de 2005, articulan en un documento las obligaciones de los Estados de proporcionar vías efectivas para la rendición de cuentas tanto en el derecho internacional humanitario como en el derecho internacional de los derechos humanos. Adoptados por la Asamblea General de la ONU, estos principios establecen el derecho de la víctima a una reparación, que abarca el deber de un Estado de investigar y procesar. Los Principios y directrices básicos requieren específicamente que los Estados sancionen a las personas culpables de violaciones graves de cualquiera de los cuerpos del derecho internacional.[37] La inclusión de esta obligación demuestra la importancia que la comunidad internacional otorga a la responsabilidad personal.

Sin embargo, el derecho a un remedio y la responsabilidad en general no se limitan al procesamiento penal.[38] Los Principios y directrices básicos “se aplican sin perjuicio del derecho a un recurso y una reparación” para todas las violaciones del derecho internacional humanitario y de los derechos humanos, no solo para los que son lo suficientemente graves como para elevarse al nivel de delitos.[39] Las normas fomentan la reparación a través del derecho civil, en particular al exigir a los Estados que hagan cumplir las sentencias relacionadas con reclamos privados presentados por las víctimas contra individuos o entidades.[40] Las opciones para la rendición de cuentas, por lo tanto, se extienden más allá del procesamiento penal al litigio civil interno. Los obstáculos a ambas opciones como respuesta a las acciones ilegales de armas completamente autónomas se tratarán en los siguientes capítulos.

III. Responsabilidad criminal

La responsabilidad criminal es una herramienta clave para castigar los actos ilícitos del pasado y disuadir a los del futuro. La comunidad internacional ha establecido esa responsabilidad por los crímenes más graves (crímenes de guerra, crímenes de lesa humanidad y genocidio), especialmente a través de tribunales especiales que responden a las atrocidades en la ex Yugoslavia y Ruanda y a través de la Corte Penal Internacional (ICC) permanente. Al explicar la importancia de la responsabilidad penal, el Tribunal de Núremberg, tribunal predecesor posterior a la Segunda Guerra Mundial, declaró: “los crímenes contra el derecho internacional son cometidos por hombres, no por entidades abstractas, y solo mediante el castigo de los individuos que cometen tales crímenes pueden cumplirse las disposiciones del derecho internacional”.[41]

Sin embargo, los robots no son humanos, y el despliegue de armas completamente autónomas podría representar un paso atrás para el derecho penal internacional. El uso de tales armas crearía la posibilidad de un vacío de responsabilidad legal personal por el tipo de daño civil asociado con los crímenes de guerra o los crímenes de lesa humanidad. Los vacíos en la responsabilidad criminal por armas completamente autónomas existirían bajo las teorías de la responsabilidad directa y la responsabilidad indirecta (también conocida como responsabilidad de mando).

Cualquier crimen consiste en dos elementos. Debe haber un acto criminal, el actus reus, y el acto debe ser perpetrado con un cierto estado mental, o mens rea. Las armas completamente autónomas podrían cometer actos criminales, un término que este informe usa para acciones que caerían bajo el elemento actus reus. Por ejemplo, un arma totalmente autónoma tendría el potencial de dirigir ataques contra civiles, matar o herir a un combatiente que se rinde o lanzar un ataque desproporcionado, todos los cuales son elementos de crímenes de guerra según el Estatuto de Roma de la ICC.[42] Por el contrario, las armas completamente autónomas no pueden tener el estado mental requerido para que estos actos ilícitos sean delitos; Debido a que no tendrían agencia moral, carecerían de la intencionalidad independiente que debe acompañar a la comisión de actos criminales para establecer la responsabilidad penal. Dado que los robots no pueden satisfacer ambos elementos de un crimen, no pueden ser considerados legalmente responsables, y uno debe considerar al operador o comandante como opciones alternativas para la rendición de cuentas. Sin embargo, a menos que un operador o comandante actuara con intención criminal o al menos con conocimiento del acto criminal del robot, habría obstáculos significativos para responsabilizar a cualquier persona por la conducta de un arma completamente autónoma según el derecho penal internacional.

Responsabilidad directa

La responsabilidad directa hace que los delincuentes sean responsables de desempeñar un papel activo en la comisión de un delito. La responsabilidad directa crea responsabilidad para el perpetrador directo, el que aprieta el gatillo; también cubre a otros actores que están directamente involucrados porque, por ejemplo, planearon u ordenaron un crimen.[43] Los robots no podrían ser considerados responsables de sus acciones bajo esta doctrina por tres razones. Primero, como se señaló anteriormente, aunque podrían cometer un acto criminal, no podrían tener el estado mental requerido para cometer un delito. Segundo, y estrechamente relacionado con este primer punto, los tribunales penales internacionales generalmente limitan su jurisdicción a las “personas físicas”, es decir, a los seres humanos, porque tienen intencionalidad para cometer delitos.[44] En tercer lugar, incluso si esta jurisdicción se expandiera, en un nivel práctico, las armas completamente autónomas no podrían ser castigadas porque serían máquinas que no podrían experimentar sufrimiento, comprender o aprender del castigo.[45] Por lo tanto, las armas completamente autónomas presentarían un nuevo vacío de responsabilidad: la entidad que selecciona y compromete a los objetivos, que hasta la fecha siempre ha sido un ser humano, no podría ser responsabilizada directamente por una acción criminal que resultara de la selección o participación ilegal de los objetivos. Sin una responsabilidad directa aplicable a las armas completamente autónomas, no habría responsabilidad por el autor real de los actos criminales que causan daños a civiles.

Además, no habría suficiente responsabilidad directa para un humano que desplegó u operó un arma totalmente autónoma que cometió un acto criminal.[46] Podría surgir un vacío debido a que las armas completamente autónomas, por definición, tendrían la capacidad de actuar de manera autónoma y, por lo tanto, podrían lanzar de forma independiente e imprevisible un ataque indiscriminado contra los civiles o hors de combat. En tal situación, independientemente de si el arma totalmente autónoma fuera concebida como un soldado subordinado bajo un comandante humano o como un arma empleada por un operador humano, la responsabilidad directa probablemente no se asociaría a un comandante u operador humano. Usando una analogía comandante-subordinado, el comandante no sería directamente responsable de las acciones específicas del robot ya que no las ordenó.[47] En el mejor de los casos, el comandante u operador solo sería responsable de desplegar el robot y la responsabilidad recaería en si esa decisión en las circunstancias equivalía a la intención de cometer un ataque indiscriminado. Algunos han argumentado que la analogía más adecuada es la de un operador que usa un arma no autónoma, pero esa posición no cambia el análisis. Todavía sería difícil atribuir una responsabilidad directa porque, en este escenario, es poco probable que el operador haya previsto que el arma causaría víctimas civiles. Según el derecho penal internacional, un ser humano podría ser directamente responsable de los actos criminales cometidos por un robot solo si implementa el robot con la intención de cometer un delito, como matar intencionalmente a civiles.[48]

Incluso si la responsabilidad directa fuera legalmente posible, habría desafíos para probar la responsabilidad. Los robots tendrían al menos dos partes que proporcionan el equivalente a las órdenes: el operador y el programador (y con frecuencia habría muchas personas involucradas en la programación). Cada parte podría tratar de culpar a los demás en un intento por evitar la responsabilidad. Por lo tanto, probar qué parte fue responsable de las órdenes que llevaron a atacar a los civiles podría resultar difícil, incluso si un usuario emplea intencionalmente armas completamente autónomas para cometer un delito.

Responsabilidad indirecta o de mando

En el derecho penal internacional, la responsabilidad indirecta, también conocida como responsabilidad de mando, considera a un comandante militar o superior civil responsable penal por no prevenir o castigar el delito de un subordinado.[49] Específicamente, la responsabilidad bajo la responsabilidad de mando ocurre cuando un superior no toma las medidas necesarias y razonables para prevenir o castigar los actos criminales de un subordinado sobre el cual el superior tiene el control efectivo, una vez que el superior conoce o tiene razones para conocer los actos criminales.[50] La responsabilidad de mando responsabiliza al superior por el incumplimiento del deber, un delito de omisión.[51] El procesamiento de la responsabilidad del mando es difícil porque generalmente requiere la cooperación del estado y la provisión de evidencia militar interna para probar los elementos de conocimiento y control efectivo.[52]

Existirían obstáculos significativos para establecer la rendición de cuentas por actos criminales cometidos por armas completamente autónomas bajo la doctrina de la responsabilidad de mando. Debido a su capacidad para realizar determinaciones independientes sobre la selección y la participación de objetivos, las armas completamente autónomas serían análogas a los soldados subordinados en el análisis de responsabilidad de mando estándar. Por lo tanto, un comandante sería teóricamente responsable bajo la responsabilidad de mando si supiera o tuviera razones para saber que el robot cometería o había cometido un crimen, no pudo prevenir o castigar al robot y tenía un control efectivo sobre el robot. Lograr este tipo de responsabilidad criminal sería un desafío legal por al menos cuatro razones.

Existencia de un crimen

Primero, la responsabilidad de mando solo surge cuando un subordinado comete un delito penal imputable.[53] El subordinado debe satisfacer todos los elementos del crimen subyacente, no simplemente intentar efectuar el crimen o cometer algún otro delito incipiente como la conspiración.[54] Como se mencionó anteriormente, los robots no pueden satisfacer el elemento mens rea de un delito y, por lo tanto, no pueden ser acusados de un delito incluso si cometen actos delictivos. Como resultado, las armas completamente autónomas como “subordinados” no pueden cometer delitos subyacentes por los cuales los comandantes podrían ser responsables bajo la responsabilidad de mando.

Conocimiento real o constructivo

Segundo, incluso si un acto criminal cometido por un robot se considerara suficiente para la doctrina de responsabilidad de mando en el caso de armas completamente autónomas, la doctrina no sería adecuada para estas armas porque sería difícil para los comandantes adquirir el nivel adecuado de conocimiento. La responsabilidad de mando solo se activa si un comandante tiene un conocimiento real o constructivo del crimen, es decir, el comandante debe saber o tener una razón para saber del crimen. El conocimiento real de un acto delictivo inminente solo ocurriría si un arma completamente autónoma comunicara su selección de objetivos antes de iniciar un ataque. Sin embargo, si un operador humano ejerciera la supervisión, la revisión efectiva y el poder de veto sobre los objetivos y ataques específicos de un robot, dicho robot sería supervisado por un humano o sea que se trataría de un arma human-on-the-loop y no constituiría el tipo de arma totalmente autónoma que se discute aquí. Suponiendo que un arma completamente autónoma esté sujeta a una supervisión no completa de sus decisiones de ataque, no se sabe con cuánta frecuencia los comandantes tendrían conocimiento real de una acción criminal inminente y mucho menos una oportunidad real de anular el ataque.

El conocimiento constructivo probablemente sería más relevante para la situación de las armas completamente autónomas. El estándar de responsabilidad de mando para el conocimiento constructivo requiere que los comandantes tengan información que los ponga “en aviso del riesgo” del crimen de un subordinado que sea “lo suficientemente alarmante como para justificar una investigación adicional”.[55] Dicha información suficientemente alarmante activa el deber de investigar y no hacerlo puede llevar a una responsabilidad de mando. Los comandantes no pueden ser considerados responsables por el hecho de no haber encontrado información sin haber recibido información alarmante.[56] El conocimiento real de los delitos pasados por parte de un conjunto particular de subordinados puede constituir información suficientemente alarmante para requerir una investigación adicional y, por lo tanto, puede constituir un conocimiento constructivo (mens rea) de futuros actos criminales.[57] Sin embargo, el análisis es muy específico de los hechos y considera las circunstancias específicas del comandante en el momento en cuestión.[58]

Esta norma plantea una serie de preguntas sobre qué constituye un conocimiento constructivo en el contexto de armas completamente autónomas. Por ejemplo, ¿el conocimiento de los actos ilegales pasados cometidos por un robot proporcionaría un aviso de riesgo solo para ese robot en particular o para todos los robots de su marca, modelo y/o programación? ¿El conocimiento de un tipo de actos ilícitos pasados, como el hecho de que un robot confunda a un civil con un combatiente (una falta de distinción), provocaría un aviso del riesgo de otros tipos de actos ilegales, como la falta de determinación precisa de la proporcionalidad de un futuro ataque? ¿Serían las armas completamente autónomas lo suficientemente predecibles para proporcionar a los comandantes el aviso de riesgo potencial requerido? ¿Dependería la responsabilidad de la comprensión individual de un comandante particular de las complejidades de la programación y la autonomía? Dependiendo de las respuestas a estas preguntas, un comandante podría escapar de la responsabilidad por los actos de un arma totalmente autónoma. Una vez que se considere a un comandante en aviso, este tendría que tomar medidas “necesarias y razonables” para evitar la actividad criminal previsible de esos robots.[59] Sin embargo, no habría responsabilidad de comando por los actos criminales de los robots hasta ese punto, porque sería injusto responsabilizar a los comandantes por actos criminales que no podrían prevenir o castigar debido a una genuina falta de conocimiento. Las incertidumbres del estándar de conocimiento en el contexto de armas completamente autónomas dificultarían la aplicación de la responsabilidad de mando.

Castigar o prevenir

Un tercer obstáculo para la aplicación de la responsabilidad de mando es el requisito de que un comandante pueda castigar o prevenir un crimen. Los robots no pueden ser castigados, por lo que una de las omisiones criminalizadas bajo el principio de responsabilidad de mando es irrelevante en el contexto de actos criminales que involucran el uso de armas completamente autónomas. Por lo tanto, la responsabilidad de mando solo podría surgir con respecto al hecho de no prevenir actos criminales con armas completamente autónomas, pero encontrar a los comandantes responsables bajo la obligación de prevenir, tendría desafíos. Como se acaba de mencionar, un comandante podría no tener un conocimiento adecuado del acto criminal para activar el deber de evitarlo. La naturaleza misma de la autonomía haría difícil predecir el próximo ataque de un robot en circunstancias cambiantes. Además, los comandantes pueden carecer de la capacidad real para evitar que las armas completamente autónomas cometan actos criminales. Por ejemplo, una ventaja clave de la autonomía, la capacidad de realizar cálculos e iniciar ataques o respuestas con mayor rapidez que el juicio humano, haría que la interrupción de un acto criminal sea particularmente difícil, incluso suponiendo que un robot posea la garantía de tener su capacidad de ataque dependiente de mantener un enlace de comunicaciones con un operador humano.[60] Finalmente, los jueces con poco conocimiento de autonomía, robótica o programación compleja pueden cuestionar la afirmación de un comandante de que el comportamiento futuro de un arma autónoma era demasiado imprevisible para merecer responsabilidad penal y/o que el comandante haya tomado todas las medidas razonables para evitar actos criminales.

Control efectivo

Cuarto, la responsabilidad de mando requeriría que los comandantes tuvieran un control efectivo sobre las armas completamente autónomas. La “capacidad material para controlar las acciones de los subordinados es la piedra de toque de la responsabilidad [de mando] individual”,[61] específicamente la “capacidad material para prevenir o castigar la conducta criminal”.[62] Como se mencionó anteriormente, la prevención en el caso de armas completamente autónomas sería difícil, y el castigo imposible. La rápida velocidad de procesamiento del arma totalmente autónoma, así como las circunstancias inesperadas, como interrupciones de comunicación, errores de programación o mal funcionamiento mecánico, podrían impedir que los comandantes pudieran cancelar un ataque. Además, la responsabilidad formal de un comandante por un subordinado, o en este caso, por un arma completamente autónoma, no garantizaría la responsabilidad de mando por los actos criminales de esa arma sin el control de facto.[63] Para cualquier acto criminal cometido durante un período sin control efectivo, no habría responsabilidad de mando.

Conclusión

La doctrina de la responsabilidad de mando podría fallar por muchas razones, entre ellas, un conocimiento insuficiente, una incapacidad para prevenir o castigar y una falta de control efectivo. Dada la ausencia de responsabilidad directa por los actos criminales de un arma completamente autónoma, cuando la responsabilidad del comando falla, la responsabilidad penal no será una opción en absoluto. El vacío en la rendición de cuentas sería especialmente problemática antes de que se notifiquen los actos criminales de un arma totalmente autónoma. Cuando un soldado humano comete un crimen, hay responsabilidad incluso si los comandantes no tienen conocimiento constructivo porque el autor real puede ser responsabilizado directamente. Si, por el contrario, un arma totalmente autónoma comete un acto criminal, ni el robot ni su comandante podrían ser responsabilizados por los delitos que ocurrieron antes de que el comandante fuera puesto en aviso. Durante este período libre de responsabilidad, un robot podría cometer actos delictivos repetidos antes de que cualquier humano tenga el deber o incluso la capacidad de detenerlo.

Los desafíos para garantizar la responsabilidad penal socavan los objetivos de la rendición de cuentas. Si no hubiera consecuencias para los operadores o comandantes humanos, los futuros actos criminales no podrían ser disuadidos, y las víctimas de armas completamente autónomas probablemente se verían a sí mismas como objetivos de ataques prevenibles por los cuales nadie fue condenado y castigado. La disuasión y retribución inadecuadas en virtud del derecho penal internacional existente plantean serias dudas sobre la sabiduría de producir y utilizar armas completamente autónomas.

IV. Responsabilidad civil

La responsabilidad civil a menudo sirve como una alternativa o complemento a la responsabilidad criminal. Bajo la ley civil, que se enfoca en los daños a los individuos en lugar de a la sociedad, las víctimas en lugar de los fiscales, presentan demandas. Los daños monetarios son la pena más común, y la compensación, junto con la estigmatización de la parte culpable, puede ayudar a las víctimas a tener un sentido de justicia y disuadir futuros actos ilícitos. Sin embargo, las consecuencias de incumplir las obligaciones en virtud del derecho civil son, sin duda, menos graves que en el derecho penal, ya que no incluyen el encarcelamiento. Los daños civiles carecen de la condena social asociada a la responsabilidad penal.

Además de las preocupaciones sobre la adecuación de la responsabilidad civil, habría obstáculos prácticos y legales significativos para responsabilizar al usuario o al fabricante de un arma totalmente autónoma bajo este cuerpo de ley.[64] Si una parte diseñó o fabricó un arma con la intención específica de matar a civiles, probablemente sería considerada legalmente responsable, al menos bajo la ley penal. Pero las situaciones que no implican una clara intención ilegal serían más desafiantes. Si bien la ley civil a menudo trata casos en los que el acusado fue imprudente o negligente, no sería factible para la mayoría de las víctimas de armas completamente autónomas presentar una demanda civil contra un usuario o fabricante. Además, el ejército y sus contratistas son en gran medida inmunes a la ley civil, al menos en algunos países, y es poco probable que las demandas por responsabilidad de productos tengan éxito contra ellos.[65]

El siguiente análisis se refiere principalmente al régimen civil de Estados Unidos, pero ese régimen es especialmente relevante para el caso de las armas completamente autónomas. Estados Unidos, que ha sido descrito como una “tierra de oportunidades” para los litigios, a menudo se percibe como poseedor del régimen de agravios más amigable para los demandantes en el mundo.[66] Si las víctimas no pueden hacer uso efectivo de los mecanismos de responsabilidad civil de Estados Unidos, es poco probable que tengan más éxito en otras jurisdicciones. Además, los fabricantes estadounidenses se encuentran entre los líderes en el desarrollo de la tecnología autónoma que conduciría a armas completamente autónomas. Por lo tanto, cualquier régimen de responsabilidad civil efectivo y completo tendría que aplicarse en el contexto de Estados Unidos.

Las dificultades prácticas de la responsabilidad civil

Las víctimas de armas completamente autónomas o sus familiares podrían enfrentar obstáculos para demandar a los usuarios o fabricantes de estas armas, incluso en un sistema legal funcional. Independientemente de si se emprenden acciones legales en Estados Unidos o en una jurisdicción diferente, las demandas pueden ser largas y costosas y requieren expertos legales y técnicos. Las barreras de tiempo, dinero y experiencia a menudo son suficientes para disuadir los litigios en un contexto puramente doméstico. Esas barreras serían aún mayores para una víctima que vive lejos del país que usó el arma totalmente autónoma, o de la sede de la compañía que la fabricó. Un abogado o una organización no gubernamental podría ayudar a las víctimas a litigar algunos casos y encontrar expertos para analizar la tecnología. Sin embargo, el gobierno probablemente respondería que la tecnología era un secreto de Estado o impondría otros obstáculos para interferir con un análisis de defectos.

Obstáculos a la responsabilidad militar

Una víctima civil de un acto ilícito cometido por un arma totalmente autónoma podría demandar a la fuerza militar que usó el arma. Por ejemplo, el pariente de alguien muerto por un arma de este tipo podría buscar reparación por una muerte injusta sobre la base de que los militares utilizaron negligente o imprudentemente un arma totalmente autónoma que era propensa a violaciones del derecho internacional humanitario o de que la usaron en situaciones específicas donde era probable que causara bajas civiles.[67] En los litigios civiles, las víctimas son mucho más propensas a demandar a la autoridad militar que al soldado individual que opera el arma. El ejército posee una capacidad financiera mayor que el individuo para proporcionar compensación, y al menos en el contexto de EE.UU., los empleados del gobierno son inmunes a las demandas civiles, excepto cuando se les acusa de violar la Constitución de EE.UU. o la demanda está autorizada por la ley.[68]

Sin embargo, incluso con este cambio hacia la responsabilidad del Estado, las víctimas probablemente no prevalecerán en su búsqueda de responsabilidad. El ejército de EE.UU. probablemente sea legalmente inmune a todas las demandas relacionadas con sus decisiones con respecto a armas completamente autónomas, y la doctrina de la inmunidad soberana protege a otros gobiernos en relación con las decisiones sobre armamento ordenadas o utilizadas, especialmente en situaciones de combate en el extranjero.[69]

El gobierno de Estados Unidos que es presuntamente inmune a las demandas civiles,[70] ha renunciado a esta inmunidad en algunas circunstancias, sobre todo en la Ley Federal de Reclamaciones por Agravios (FTCA, por sus siglas en inglés). La exención está sujeta a algunas excepciones. Sin embargo, tres de ellas son particularmente relevantes cuando se trata de militares: (1) la excepción de la función discrecional; (2) la excepción de las actividades de combate; y (3) la excepción del país extranjero.[71] Si un caso cae bajo alguna de estas excepciones, entonces el gobierno es inmune a la demanda.

La excepción de la función discrecional significa, en esencia, que las agencias gubernamentales no pueden ser demandadas por acciones tomadas mientras se implementan los objetivos políticos del gobierno.[72]Actos como la selección de diseños de equipos militares o la opción de usar un arma totalmente autónoma en un entorno particular podrían estar cubiertos por esta excepción.[73] Los tribunales de Estados Unidos a menudo son reacios a investigar demasiado a fondo las políticas de asuntos exteriores del gobierno, incluidos los mecanismos de toma de decisiones militares.[74] Por lo tanto, probablemente aplicarían esta excepción si se enfrentaran con un caso iniciado por la víctima de un arma totalmente autónoma.

La excepción de las actividades de combate inmuniza al gobierno de reclamos civiles relacionados con las actividades de combate en guerra de las fuerzas militares, el contexto más probable para el uso de armas completamente autónomas.[75] Los tribunales han definido la excepción para incluir el conflicto armado fuera de una guerra declarada formalmente y cualquier actividad relacionada con las hostilidades, no solo las actividades armadas.[76] Por ejemplo, los herederos de los pasajeros fallecidos del Vuelo 655 de Iran Air, un avión civil iraní que fue derribado por el buque de guerra USS Vincennes, fueron excluidos de demandar a Estados Unidos debido a la inmunidad soberana bajo la excepción de las actividades de combatientes.[77]

La excepción de país extranjero prohíbe que los individuos presenten reclamos contra el gobierno de EE.UU. “que surjan en un país extranjero”.[78] Esta excepción se ha interpretado ampliamente para restringir los reclamos civiles relacionados con conductas que ocurren en el extranjero, incluso si las actividades fueron planeadas por miembros del gobierno de Estados Unidos en territorio nacional.[79] Por ejemplo, esta disposición impidió que el patrimonio de un ingeniero muerto en un accidente en una base aérea militar estadounidense en Canadá, demandara al gobierno de EE.UU. por una indemnización.[80] Esta excepción limitaría drásticamente las reclamaciones basadas en el despliegue de armas completamente autónomas por parte de las fuerzas estadounidenses en los compromisos en el extranjero.

Por lo tanto, el ejército de EE.UU. probablemente gozaría de inmunidad ante cualquier reclamo relacionado con el desarrollo o uso de armas completamente autónomas porque involucraría decisiones políticas y/o una conducta en tiempos de guerra o porque tuvieron lugar en el extranjero. Incluso las jurisdicciones con doctrinas de inmunidad altamente restrictivas como el Reino Unido bien podrían excluir este tipo de demandas. La Corte Suprema británica recientemente y de manera controvertida, permitió que las familias de los soldados británicos que murieron en Irak demandaran al gobierno británico por negligencia y violaciones de derechos humanos. Sin embargo, el tribunal declaró que el Ministerio de Defensa del Reino Unido era inmune a las “decisiones políticas de alto nivel (...) o decisiones tomadas en el fragor de la batalla”.[81]

Obstáculos a la responsabilidad del fabricante

Si un arma totalmente autónoma matara o lesionara a un no combatiente como resultado de fallas en la producción, programación o diseño, un método para lograr al menos una responsabilidad parcial sería responsabilizar al fabricante que creó y programó el arma. Sin embargo, hacerlo sería extremadamente difícil. Según las leyes de Estados Unidos los contratistas militares a menudo gozan de inmunidad ante una demanda civil. Además, la ley de responsabilidad de productos, el método más común para imponer responsabilidad civil a los fabricantes, no puede acomodar adecuadamente las reclamaciones relativas a dispositivos autónomos que son capaces de realizar determinaciones independientes.

Inmunidad para los fabricantes militares

Los contratistas militares, como el propio ejército, suelen ser inmunes a los litigios en los tribunales de Estados Unidos como una extensión de la propia inmunidad del gobierno por dos razones. Primero, los tribunales de Estados Unidos han encontrado que los contratistas militares son inmunes en casos que involucran un arma cuyo diseño eligió el gobierno. Los fabricantes no pueden responsabilizarse por ningún daño causado por un arma defectuosa si: (1) el gobierno aprobó especificaciones precisas para el arma, (2) el arma se ajustó a esas especificaciones, y (3) el fabricante no informó deliberadamente al gobierno de un peligro conocido con respecto al arma que el gobierno desconocía.[82] Esta norma legal prohibió, por ejemplo, una demanda contra el fabricante de un helicóptero que se estrelló, matando a un militar.[83]

Mientras los militares participaran activamente en el desarrollo de armas completamente autónomas, y no se limitaran a “sellar” las decisiones de diseño del contratista o a comprar armas con un diseño estandarizado, los fabricantes probablemente escaparían de la responsabilidad por su papel en el suministro de las armas.[84] Debido a que las armas completamente autónomas serían altamente complejas y adaptadas a situaciones específicas, los militares casi seguramente desempeñarían un papel importante en su diseño y desarrollo, y sus fabricantes, por lo tanto, serían inmunes a las demandas.[85]

En segundo lugar, los contratistas militares de Estados Unidos, como el propio ejército, son inmunes a los reclamos que surgen de las actividades en tiempos de guerra. Por ejemplo, el fabricante del arma de defensa aérea que derribó el avión civil iraní en el incidente de Vincennes mencionado anteriormente, estaba sujeto a inmunidad porque el caso involucraba una “actividad de combatiente”.[86] Del mismo modo, el fabricante de un misil que atacó accidentalmente a las fuerzas amigas en la frontera entre Kuwait y Arabia Saudita resultó inmune bajo esta excepción.[87] Por la misma razón, es probable que los fabricantes no enfrenten responsabilidad por el uso de armas completamente autónomas en combate.

Las lagunas en la ley de responsabilidad de productos

En teoría, la ley de responsabilidad de productos ofrecería otra vía para la responsabilidad civil para los fabricantes de armas completamente autónomas.[88] Esta área del derecho civil hace que las entidades dedicadas al negocio de diseñar, producir, vender o distribuir productos sean responsables de daños a personas o propiedades causados por defectos en esos productos.[89]

La ley de responsabilidad de productos no fue desarrollada para hacer frente a la tecnología autónoma. Incluso si los contratistas militares no fueran inmunes a las reglas discutidas anteriormente, los demandantes tendrían grandes dificultades para tener éxito en una demanda por responsabilidad de productos contra los fabricantes de armas completamente autónomas. Las víctimas de un arma completamente autónoma podrían demandar al fabricante del arma argumentando que existía un defecto de fabricación o diseño, pero ninguna teoría de defectos podía ser fácilmente invocada en casos de armas totalmente autónomas.[90]

Defectos de fabricación

Un defecto de fabricación se refiere a la falla de un producto para cumplir con sus especificaciones de diseño.[91] Por ejemplo, si el volante de un automóvil es defectuoso y se atasca o si un microondas se quema espontáneamente, es probable que haya un defecto de fabricación porque es probable que los productos no funcionen como se diseñaron. Los fabricantes de armas completamente autónomas estarían sujetos a este tipo de reclamación si un demandante argumentara que el arma no funcionó de la manera prevista por el fabricante. Hay dos dificultades principales en la aplicación de la doctrina de defectos de fabricación a sistemas autónomos.

Primero, esta doctrina se usa generalmente en el caso de defectos tangibles (como la explosión de un microondas) y parece no haberse aplicado a un software supuestamente defectuoso porque “no se fabrica nada tangible”.[92] Sin embargo, es precisamente la decisión independiente basada en software y la capacidad de las armas completamente autónomas las que serían las más relevantes desde una perspectiva legal y ética.

En segundo lugar, incluso si a los demandantes no se les prohibiera necesariamente hacer reclamos con respecto a defectos de fabricación basados en software, sería difícil para ellos probar la existencia de tal defecto en un arma totalmente autónoma. Estos tipos de casos generalmente involucran a demandantes que le piden a la corte que deduzca un defecto de fabricación basado en la falla de un producto sin la prueba del defecto específico en sí.[93] Por ejemplo, si los frenos de un automóvil fallan, un tribunal puede usar ese hecho para inferir la existencia de un defecto de fabricación, incluso si el demandante no pudiera señalar un problema particular con los frenos porque normalmente se puede suponer que los frenos que funcionan como se diseñaron no fallarían.[94]

Sin embargo, en el caso de armas completamente autónomas, el mero hecho de que tal arma matara a civiles sería insuficiente para probar que el arma falló y no actuó de acuerdo con el diseño.[95] Incluso si un arma totalmente autónoma fuera diseñada para proporcionar respuestas militares adecuadas que cumplieran con el derecho internacional humanitario, ese cuerpo legal permitiría el asesinato incidental de civiles conocidos en ciertas situaciones, como cuando un ataque es discriminatorio (es decir, se dirige a objetivos militares) y proporcional (es decir, la ventaja militar es mayor que el daño civil posible). La muerte de un civil podría ser consistente con un rendimiento adecuado tanto en la fabricación como en el diseño. Alternativamente, el asesinato podría deberse a un mal funcionamiento en la programación o hardware o a un diseño defectuoso que no proporcionó una respuesta legalmente compatible en una situación dada. Los conflictos armados pueden presentar circunstancias muy fluidas, impredecibles y complejas, y al desarrollar armas completamente autónomas, los programadores y fabricantes podrían no predecir todas las situaciones a las que podría enfrentarse tal arma. Por lo tanto, sería difícil discernir el mal funcionamiento solo de una falla en la programación o el diseño de las innumerables contingencias que requieren el cumplimiento legal.

Debido a estos problemas, la dificultad inherente de señalar defectos específicos en software no físico y la dificultad de inferir un defecto de un mal funcionamiento, las reclamaciones de defectos de fabricación no serían opciones viables en el caso de armas completamente autónomas.

Defectos de diseño

Un defecto de diseño implica el diseño de producto que presenta un riesgo de daño previsible e irrazonable que podría haberse reducido o evitado con un diseño alternativo razonable.[96] En este tipo de casos, el demandante afirmaría que el diseño mismo de armas completamente autónomas era inherentemente defectuoso, quizás debido a la incapacidad de estas armas para cumplir adecuadamente con el derecho internacional humanitario. Al igual que las reclamaciones por defectos de fabricación, es improbable que este tipo de demandas tengan éxito. Existen dos enfoques principales para diseñar defectos: uno enfocado en las expectativas de los consumidores y el otro sobre los riesgos asociados con un producto. De la misma forma, tampoco sería adecuado para reclamaciones derivadas de las acciones de máquinas autónomas.

Bajo la prueba de expectativas del consumidor, los demandantes pueden demostrar la existencia de un defecto de diseño al afirmar que un diseño en particular es inconsistente con las expectativas de seguridad de los consumidores comunes.[97] Este tipo de análisis a veces se usa para tecnologías con las que los consumidores comunes están muy familiarizados, pero en general se encuentra desfavorecido cuando se trata de tecnología lo suficientemente complicada como para que los consumidores no tengan, según los tribunales, “expectativas razonables” con respecto a sus capacidades.[98] Por ejemplo, los tribunales de EE.UU. han descubierto que la tecnología, como las bolsas de aire o el control de crucero, es demasiado complicada para que se aplique esta norma.[99] Teniendo en cuenta que incluso el arma autónoma más básica sería mucho más compleja y sofisticada que un sistema de control de crucero de un automóvil, las víctimas presumiblemente enfrentarán obstáculos significativos para seguir este enfoque.

Bajo la prueba de riesgo-utilidad, el demandante demuestra la existencia de un defecto de diseño al mostrar que los riesgos planteados por un producto superan los beneficios.[100] Al analizar si un fabricante debe ser responsable de un defecto de diseño, los tribunales de EE.UU. pueden tener en cuenta los posibles daños que podría causar un producto, la existencia de diseños alternativos más seguros en la misma categoría y/o la idoneidad de la advertencia de riesgos para el consumidor.[101] Aplicar estos factores a armas completamente autónomas es problemático dado que el fabricante podría afirmar que la tecnología beneficia en lugar de dañar al público y al ejército al reducir la amenaza de las fuerzas amigas. Sin embargo, este equilibrio no es el requerido por el derecho internacional humanitario, que hace hincapié en la protección de los civiles contra daños innecesarios en lugar de la protección de la fuerza. Al menos hasta que la tecnología esté ampliamente disponible, probablemente haya pocos productos similares con los que comparar las armas en cuestión. Además, los riesgos para la vida humana involucrados en el uso de armas mortales son tan obvios que podría ser difícil argumentar que las advertencias generales eran necesarias y las advertencias más específicas podrían no ser útiles dada la imprevisibilidad inherente en las armas completamente autónomas. La complejidad de los sistemas autónomos también crearía una barrera práctica para este tipo de casos porque los demandantes tendrían que contratar costosos testigos expertos para testificar sobre diseños alternativos.[102]

Además de enfrentar dificultades en la aplicación de las dos pruebas, los tribunales pueden tener razones políticas para abstenerse de responsabilizar a los fabricantes de armas completamente autónomas según la teoría de defectos de diseño. Cuando se trata de productos ordinarios, los tribunales han encontrado responsables a los fabricantes en lugar de a los consumidores del mercado masivo porque se considera que los fabricantes están en la mejor posición para garantizar que un producto no esté defectuoso.[103] Después de todo, ellos son los que diseñan y producen el producto. Esta conclusión sería mucho menos razonable o intuitiva cuando se tratase de armas completamente autónomas fabricadas por un contratista militar para un comprador militar altamente sofisticado que especifique usos anticipados.[104] Estas armas presumiblemente se producirían a medida para clientes gubernamentales a través de negociaciones de adquisición específicas y requisitos de contrato. En este caso, los tribunales probablemente verían como objetivo apropiado para una demanda a las autoridades militares que encargaron y establecieron las especificaciones para el arma, en lugar de al fabricante que estaba siguiendo las instrucciones en gran medida. Por razones similares, los tribunales de EE.UU. no han permitido demandas contra fabricantes de trenes fabricados a medida[105] o equipos de fábrica diseñados a medida.[106]

Un sistema de compensación sin fallas

Dadas las dificultades para aplicar el derecho civil a sistemas autónomos complejos, una alternativa sería adoptar un esquema de compensación sin culpa para armas completamente autónomas. A diferencia de un régimen de responsabilidad de productos, requeriría solo una prueba de daño, no una prueba de defecto. De este modo, las víctimas podrían recibir asistencia financiera o en especie similar a la otorgada en otras demandas civiles sin tener que superar los obstáculos probatorios relacionados con la prueba de un defecto. Tales sistemas sin fallas a menudo se usan donde un producto o actividad a veces altamente peligroso se considera socialmente valioso; facilitan el empleo del producto arriesgado pero es útil al proporcionar compensación a las víctimas, establecer cierta previsibilidad y establecer límites a los costos del acusado. Este tipo de sistema sin fallas se ha utilizado para compensar a las personas afectadas por vacunas.[107] También se ha propuesto en el contexto de automóviles autónomos, que comparten muchas de las mismas barreras legales, para adaptarse a las armas completamente autónomas.[108]

Bajo un esquema sin culpa, las víctimas o sus familias presentarían un reclamo ante el gobierno que usó un arma totalmente autónoma que causó daños a civiles y recibirían compensación. No tendrían que mostrar negligencia, imprudencia o culpa por el daño; mientras se produjera el daño, la indemnización sería debida.

Hay varios problemas con un esquema sin culpa para armas completamente autónomas. Primero, es difícil imaginar que muchos gobiernos estén dispuestos a poner en práctica tal régimen legal.[109] En segundo lugar, no está claro de ninguna manera que el valor social de las armas completamente autónomas supere sus riesgos aparentes y justifique un régimen de este tipo. Estas máquinas estarían diseñadas para tomar decisiones independientes sobre objetivos e incluso matar a algunos civiles en el proceso y, cuando funcionaran mal, podrían atacar a civiles o causar daños civiles desproporcionados o innecesarios. Su “valor social” se basaría en cuestiones de protección de costos o fuerzas, que no es un objetivo del derecho internacional humanitario, o en la posibilidad poco probable de que los robots superen a los seres humanos en las determinaciones morales y analíticas extremadamente difíciles que exige la ley humanitaria internacional. En tercer lugar, si bien un esquema sin fallas de este tipo podría ayudar a los perjudicados por armas completamente autónomas y, por lo tanto, ayudaría a lograr un objetivo compensatorio importante, haría poco para garantizar una rendición de cuentas significativa. Compensar a una víctima por el daño es diferente de asignar responsabilidad, lo que implica disuasión, culpa moral y el reconocimiento por parte de la sociedad y el delincuente, del agravio cometido contra la víctima. Por su propia naturaleza, un esquema sin culpa está más centrado en los objetivos políticos que son importantes, pero sustitutos limitados del significativo sistema de responsabilidad exigido tanto por el derecho internacional como por el principio moral.[110]

Conclusión

Los mecanismos de responsabilidad civil no pueden llenar el vacío de responsabilidad causado por el incumplimiento de las normas del derecho penal tradicional para hacer frente a la llegada de armas completamente autónomas. Debido a la amplia inmunidad otorgada a los militares y sus contratistas, así como a los desafíos planteados por la ley de responsabilidad de los productos, confiar en demandas civiles para cubrir el vacío de responsabilidad asociada con las armas completamente autónomas sería poco práctico, irreal y legalmente incierto. Además, incluso si alguien fuera civilmente responsable, la responsabilidad resultante no sustituiría la responsabilidad criminal en términos de disuasión, justicia retributiva o estigma moral.

Conclusión

Los obstáculos a la rendición de cuentas para la producción y el uso de armas completamente autónomas según la ley actual son monumentales. Las armas en sí mismas no podrían ser consideradas responsables de su conducta. Dado que no podrían actuar con intención criminal, quedarían fuera de la jurisdicción de los tribunales internacionales y no podrían ser castigadas. La responsabilidad penal probablemente se aplicaría solo en situaciones en las que los humanos intentaron específicamente usar los robots para violar la ley. Al menos en Estados Unidos, la responsabilidad civil sería virtualmente imposible debido a la inmunidad otorgada por la ley a los militares y sus contratistas y los obstáculos probatorios a las demandas de responsabilidad por productos.